机构名称:

¥ 1.0

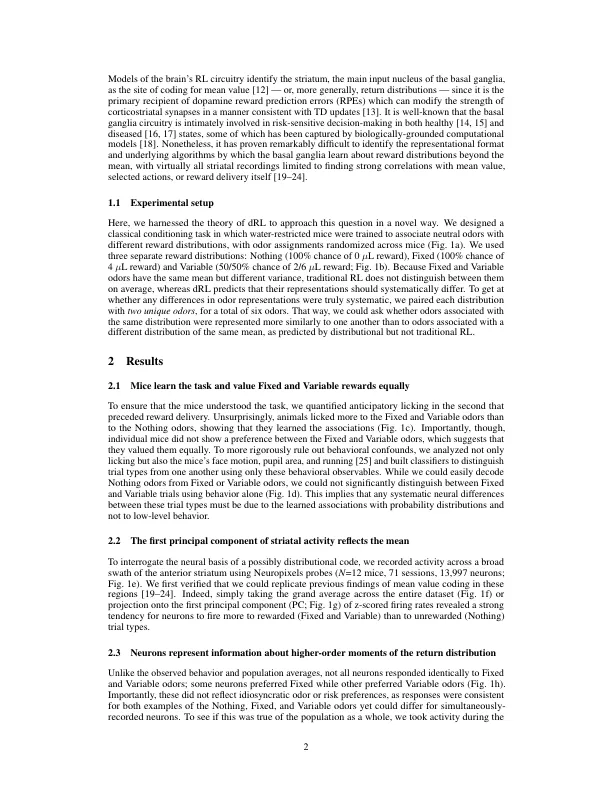

分布式强化学习 (dRL) —— 学习预测的不仅是平均回报,还有回报的整个概率分布 —— 在广泛的基准机器学习任务中取得了令人印象深刻的表现。在脊椎动物中,基底神经节强烈编码平均值,长期以来被认为是实现 RL 的,但对于该回路中的神经元群是否、在何处以及如何编码有关奖励分布高阶矩的信息知之甚少。为了填补这一空白,我们使用 Neuropixels 探针来敏锐地记录执行经典条件反射任务的训练有素、缺水的小鼠的纹状体活动。在几个表征距离测量中,与相同奖励分布相关的气味彼此之间的编码相似度要高于与相同平均奖励但不同奖励方差相关的气味,这与 dRL 的预测一致,但不是传统 RL。光遗传学操作和计算建模表明,遗传上不同的神经元群编码了这些分布的左尾和右尾。总的来说,这些结果揭示了 dRL 与哺乳动物大脑之间显著的融合程度,并暗示了同一总体算法的进一步生物学专业化。

哺乳动物大脑中的分布式强化学习