机构名称:

¥ 1.0

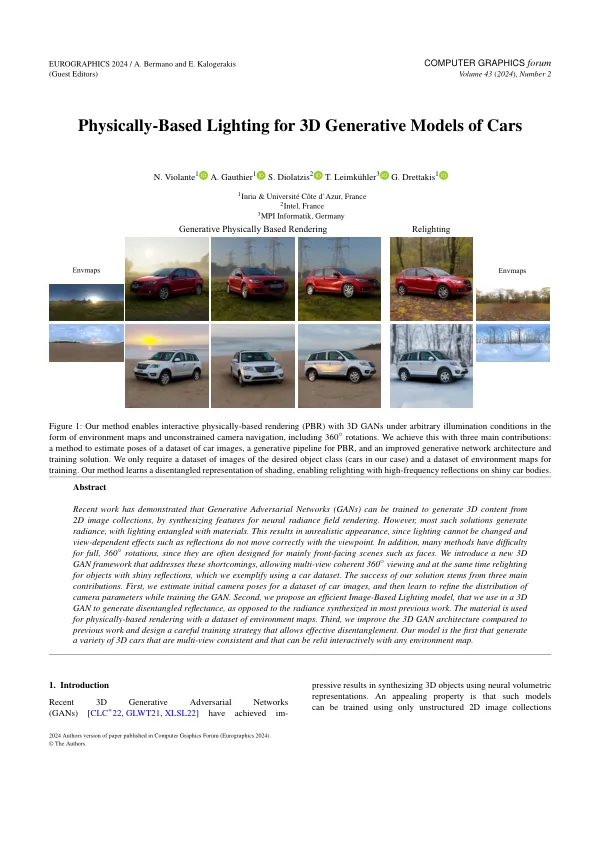

最近的工作表明,可以通过合成神经辐射场渲染的特征来训练生成的对抗网络(GAN)从2D图像集合中生成3D内容。但是,大多数这样的解决方案都会产生光彩,并与材料纠缠在一起。这会导致不切实际的外观,因为照明无法更改,并且依赖视图(例如反射)的效果无法正确移动。此外,许多方法对于完整的360°旋转都很难,因为它们通常是专为面孔诸如面孔的主要场景而设计的。我们引入了一个新的3D GAN框架,该框架解决了这些缺点,允许多视图相干360◦查看,同时重新查看具有闪亮反射的对象,我们使用CAR数据集进行了体现。我们解决方案的成功源于三个主要贡献。首先,我们估算了最初的摄像头为汽车图像数据集,然后在训练GAN时学会完善相机参数的分布。第二,我们提出了一个有效的基于图像的照明模型,我们在3D GAN中使用该模型来产生分离的反射率,而不是在以前的大多数工作中合成的辐射。该材料用于使用环境图的数据集进行基于物理的渲染。第三,我们与以前的工作相比,我们改善了3D GAN体系结构,并设计了允许有效分解的仔细培训策略。我们的模型是第一个生成各种3D汽车一致的3D车,并且可以与任何环境图进行交互式保存。

3D生成模型的基于物理的照明

主要关键词