机构名称:

¥ 1.0

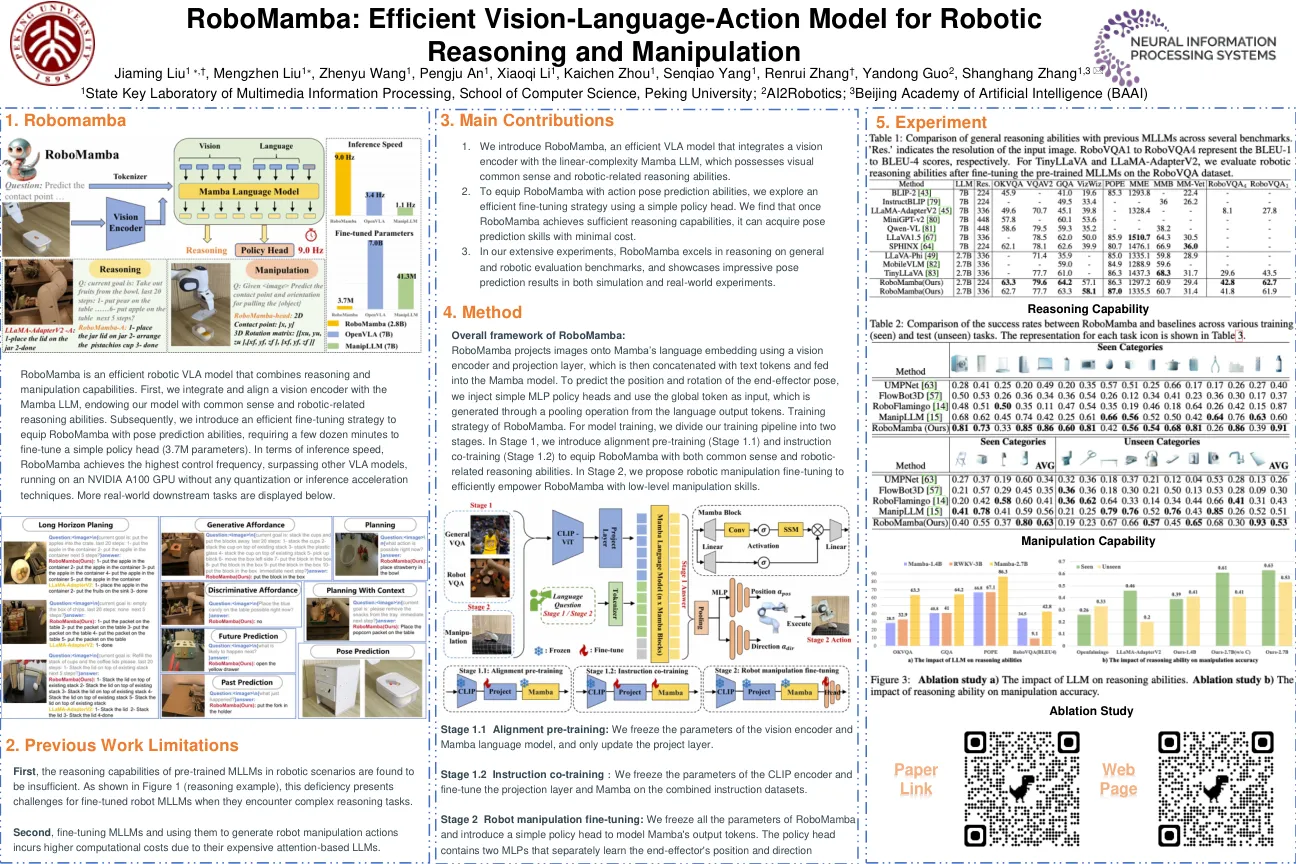

在本研究中,我们使用视觉语言模型 (VLM) 作为二元成功检测器,给定机器人观察和任务描述,将其表述为视觉问答 (VQA) 问题。我们对开源 MiniGPT-4 VLM 进行了微调,以检测来自 Berkeley Bridge 和 Berkeley AUTOLab UR5 数据集的机器人轨迹上的成功。我们发现,虽然少量测试分布轨迹可以训练出准确的检测器,但由于分布偏移,在不同环境之间迁移学习具有挑战性。此外,虽然我们的 VLM 对语言变化具有鲁棒性,但对视觉变化的鲁棒性较差。未来,更强大的 VLM(例如 Gemini 和 GPT-4)有可能成为更准确、更强大的成功检测器,并且成功检测器可以提供稀疏的二元奖励来改进现有策略。

用于机器人成功检测的视觉语言模型