机构名称:

¥ 1.0

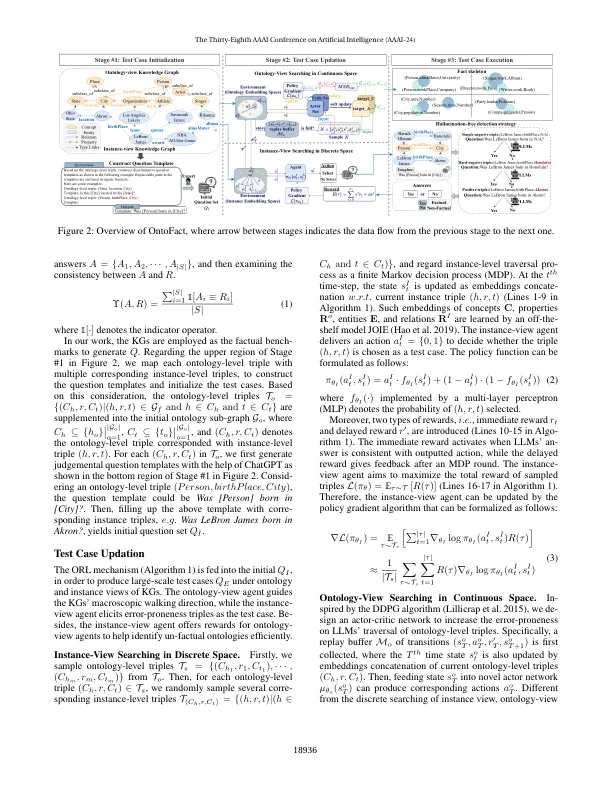

大型语言模型(LLM)表现出了信息检索的熟练程度,而它们容易产生与现实冲突的不正确反应,这种现象被称为固有幻觉。关键挑战在于经过大量数据训练的LLM中不清楚和不可靠的事实分布。vreva-liment方法将事实检测任务视为一个问题 - 回答范式,在其中询问了LLMS有关FACTUAL知识并检查正确性的问题。但是,研究主要侧重于仅从几个特定领域(例如电影和运动)中得出测试用例,从而限制了对知识缺失的全面观察和对意外幻觉的分析。为了打扮这个问题,我们提出了构造,这是一个自适应框架,用于检测LLM的未知事实,致力于挖掘缺失知识的本体论级骨架。特定说明,我们认为LLM可以在缺失的事实中公开基于本体的相似性,并将五个代表知识图(kgs)作为基准。我们进一步设计了一种复杂的本体驱动的强化学习(ORL)机制,以自动与特定实体和关系产生易错的测试用例。Orl Mechamenism奖励KGS朝着可行的方向导航,以揭示事实错误。此外,经验努力表明,无论是否包括这些知识,主导的LLM都倾向于回答是的,而不是否定。使用32个代表性LLM的5个数据集上的实验结果表明,当前LLMS总体上缺乏事实。为了减轻LLM的过度自信,我们利用了无幻觉检测(HFD)策略来解决基线之间的不公平比较,从而提高了结果的稳健性。值得注意的是,CHATGPT在DBPEDIA上的事实错误率分别为51.6%,Yago的错误率分别为64.7%。另外,ORL机制显示出令人鼓舞的误差预测分数,大多数LLM的F1分数范围从70%到90%。与详尽的测试相比,ORL的平均召回率为80%,同时将评估时间降低35.29%至63.12%。

antofact:通过本体驱动的强化学习揭示了LLM的奇妙事实 - 骨骼

主要关键词