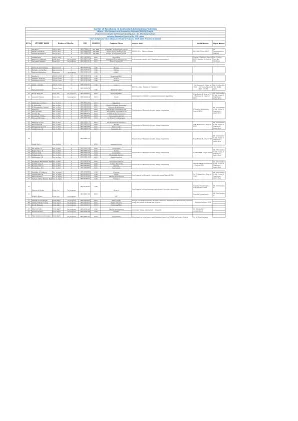

机构名称:

¥ 1.0

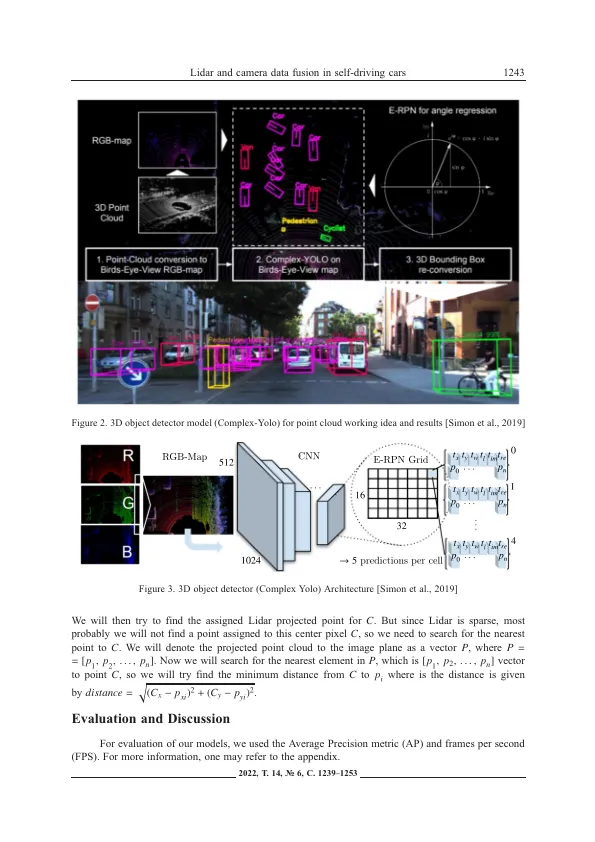

传感器融合是自动驾驶汽车中感知问题的重要解决方案之一,其中主要目的是增强对系统的感知而不会失去实时性能。因此,这是一个权衡问题,通常观察到大多数具有高环境感知的模型无法实时执行。我们的文章与相机和激光雷达数据融合有关,以实现自动驾驶汽车的更好环境感知,考虑到3个主要类别是汽车,骑自行车的人和行人。我们从3D检测器模型中融合了输出,该模型从LiDar中获取了其输入以及从相机中获取其输入的2D检测器的输出,以比单独分别提供更好的感知输出,以确保其能够实时工作。我们使用3D检测器模型(复杂的Yolov3)和2D检测器模型(YOLO-V3)解决了问题,其中我们应用了基于图像的融合方法,该方法可以在本文中详细讨论了LIDAR和摄像机信息之间的融合和相机信息之间的融合。我们使用平均平均精度(MAP)度量,以评估我们的对象检测模型并将所提出的方法与它们进行比较。最后,我们在Kitti数据集以及我们的真实硬件设置上展示了结果,该设置由LIDAR Velodyne 16和Leopard USB摄像机组成。我们使用Python开发了我们的算法,然后在Kitti数据集上验证了它。我们将ROS2与C ++一起使用,以验证从硬件配置获得的数据集上的算法,证明我们提出的方法可以以实时的方式在实际情况下有效地提供良好的结果并有效地工作。

自动驾驶汽车中的LIDAR和相机数据融合

主要关键词