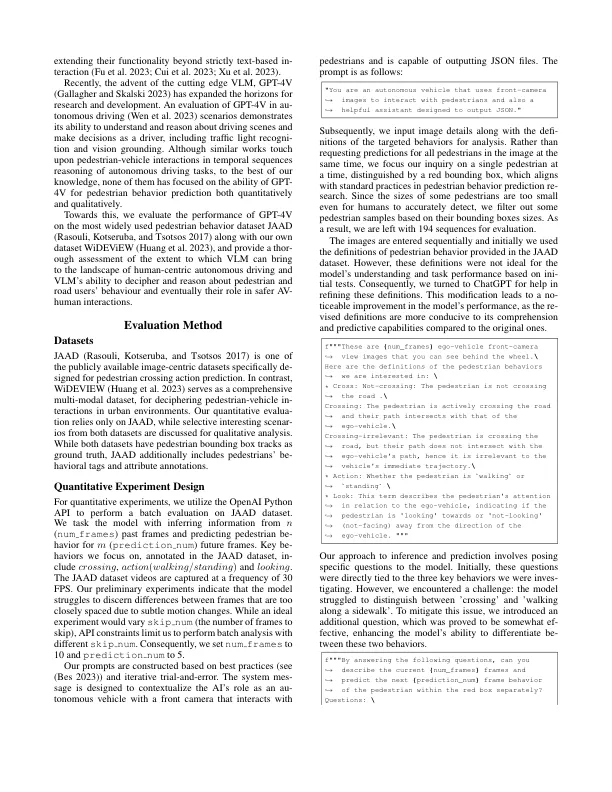

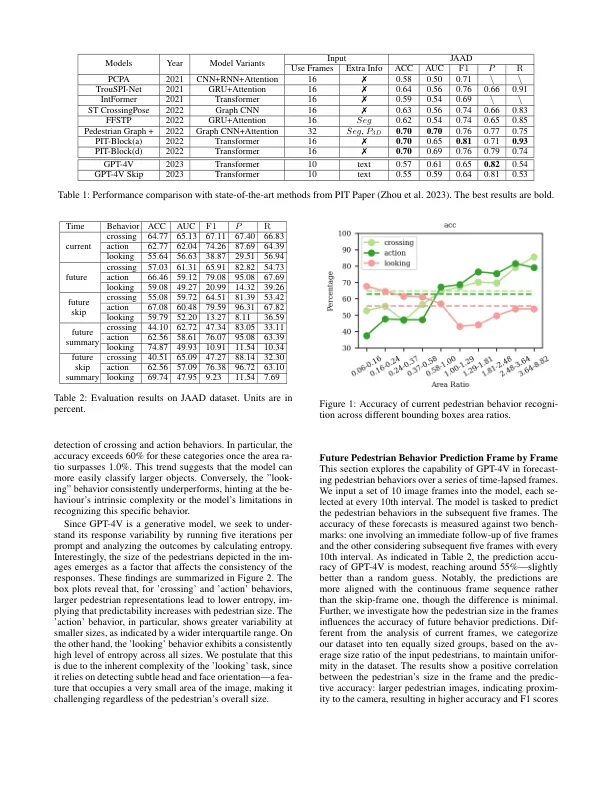

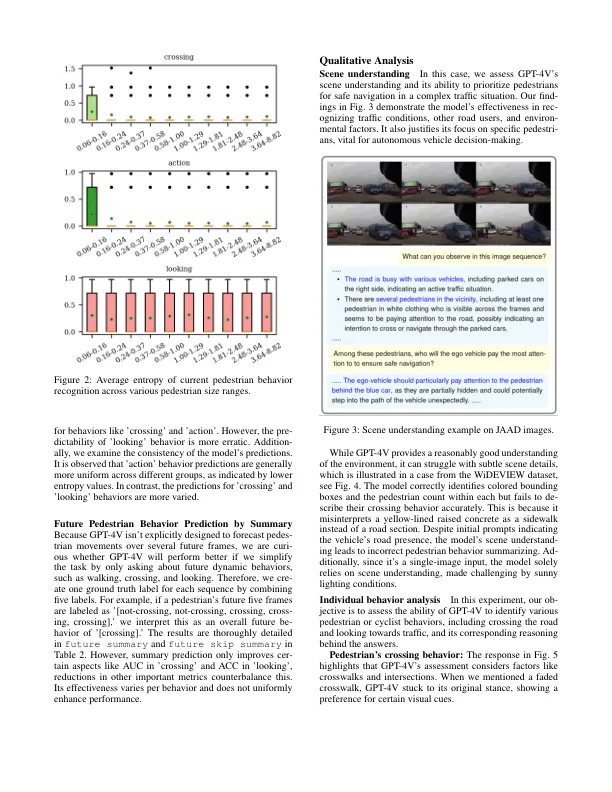

预测行人行为是确保自动驾驶汽车安全性和可靠性的关键。尽管通过从注释的视频框架序列中学习深入学习方法,但他们通常无法完全掌握行人与交通之间的动态相互作用,但可以进行准确的预测。这些模型也缺乏细微的常识推理。此外,这些模型的数据集的手动注释既昂贵又挑战,以适应新情况。视觉语言模型(VLM)的出现,由于其先进的视觉和因果推理技能,引入了这些问题的有希望的替代方案。据我们所知,这项研究是第一个在自主驱动的行人行为预测的概述中对VLM进行定量和定性评估的研究。 我们在公开可用的Pedes-Trian数据集上评估GPT-4V(ISION):JAAD和Wideview。 我们的定量分析重点是GPT-4V预测当前和未来帧中行人行为的能力。 该模型以零拍的方式达到了57%的精度,尽管令人印象深刻,但仍落后于最新的域特异性模型(70%),以预测行人交叉行动。 定性,GPT-4V表现出令人印象深刻的处理和解释综合交通情况,区分各种脚步行为以及检测和分析组的能力。 但是,它面临着挑战,例如难以检测较小的脚步 - 评估行人与自我车辆之间的相对运动。据我们所知,这项研究是第一个在自主驱动的行人行为预测的概述中对VLM进行定量和定性评估的研究。我们在公开可用的Pedes-Trian数据集上评估GPT-4V(ISION):JAAD和Wideview。我们的定量分析重点是GPT-4V预测当前和未来帧中行人行为的能力。该模型以零拍的方式达到了57%的精度,尽管令人印象深刻,但仍落后于最新的域特异性模型(70%),以预测行人交叉行动。定性,GPT-4V表现出令人印象深刻的处理和解释综合交通情况,区分各种脚步行为以及检测和分析组的能力。但是,它面临着挑战,例如难以检测较小的脚步 - 评估行人与自我车辆之间的相对运动。

对行人行为预测的承诺和挑战

主要关键词