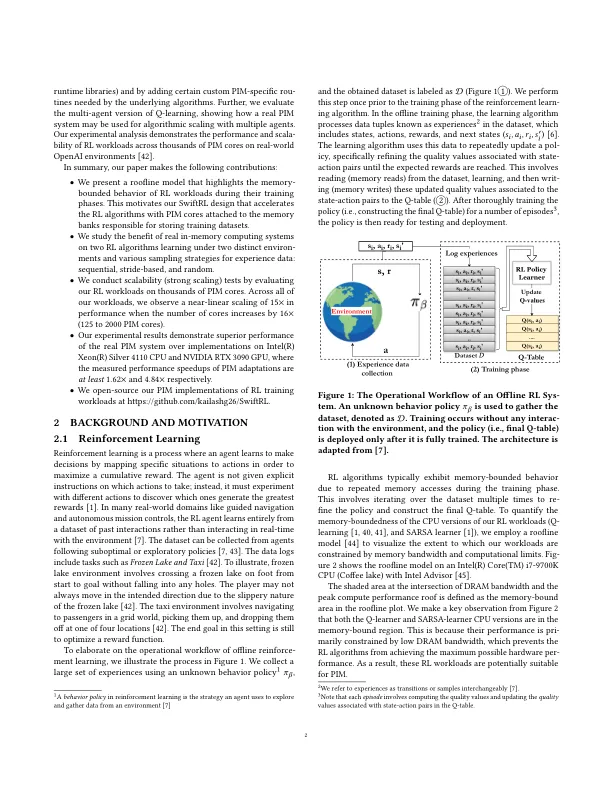

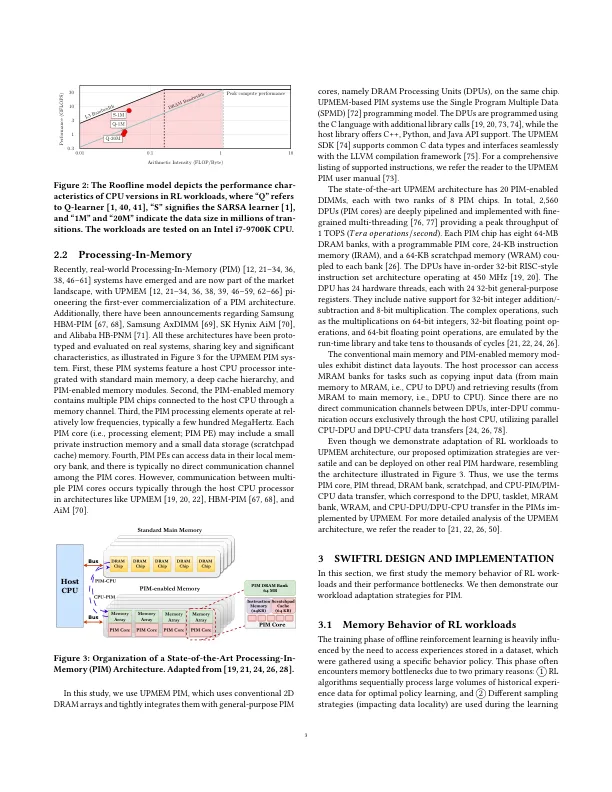

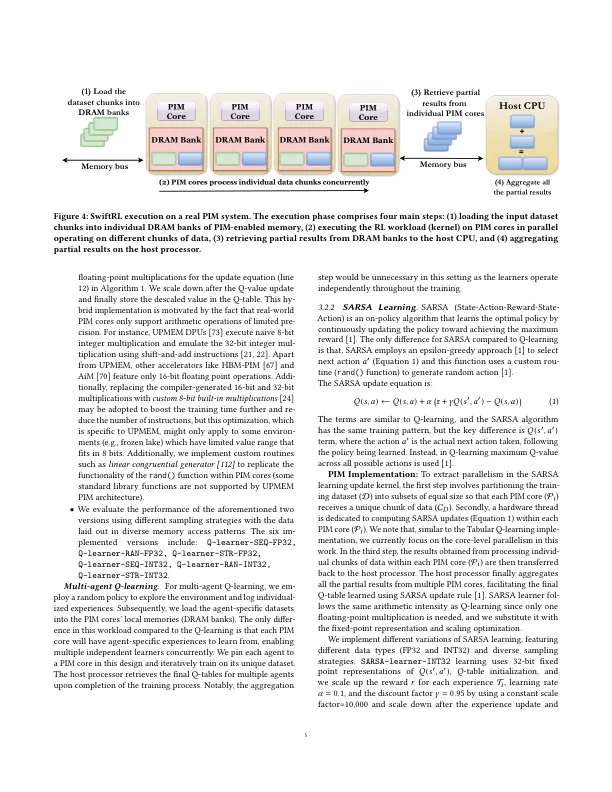

增强学习(RL)是代理通过与经验数据集进行交互来学习最佳行为的过程,所有这些都旨在最大化奖励信号。rl算法通常在现实世界应用中面临性能挑战,尤其是在使用广泛而多样的数据集培训时。例如,诸如自动驾驶汽车之类的应用程序包括感官数据,Dy-Namic的交通信息(包括其他车辆和行人的运动),关键的风险评估以及各种代理行动。因此,由于对大量体验数据集进行了抽样,因此RL训练可能完全不适合硬件缓存,并且在内存和计算单元(例如CPU,GPU)之间所需的频繁数据传输,尤其是批量批次更新。这种瓶颈会产生大量的执行潜伏期,并影响整体培训时间。为了减轻最近提出的以内存为中心的计算范例(例如内存中的处理(PIM)),可以通过执行内存设备内的计算来解决与内存延迟相关的瓶颈。在本文中,我们介绍了Swiftrl,该文章探讨了现实世界中PIM体系结构加速流行的RL工作负载及其培训阶段的潜力。我们在Upmem Pim系统上调整了RL算法,即Tabular Q-Learning和SARSA,并首先使用两种不同的环境和三种采样策略观察他们的性能。此外,我们开发和评估了针对硬件优化的Q学习的多代理版本,并说明了如何使用多个代理来利用PIM进行算法缩放。然后,我们通过近似Q值更新功能(由于运行时库使用的运行时指令仿真而避免了高性能成本),并结合了基础算法所需的某些PIM特异性例程,从而实现了RL适应PIM期间的性能选择策略。我们使用Upmem硬件在OpenAI健身房环境上实验评估RL工作负载。我们的结果表明,当PIM核心数量增加16×(125至2000)时,性能的近线性缩放比例为15倍。我们还将我们的PIM实施与Intel(R)Xeon(R)Silver 4110 CPU和NVIDIA RTX 3090 GPU进行了比较,并在Upmem PIM系统上观察到具有不同实现的UPMEM PIM系统。

swiftrl:迈向对内存系统实际处理的有效加强学习

主要关键词