机构名称:

¥ 1.0

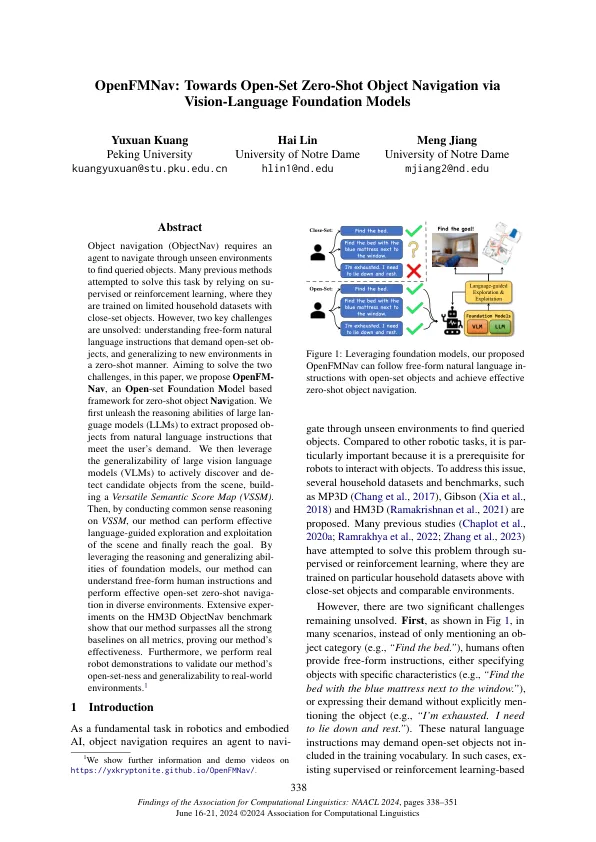

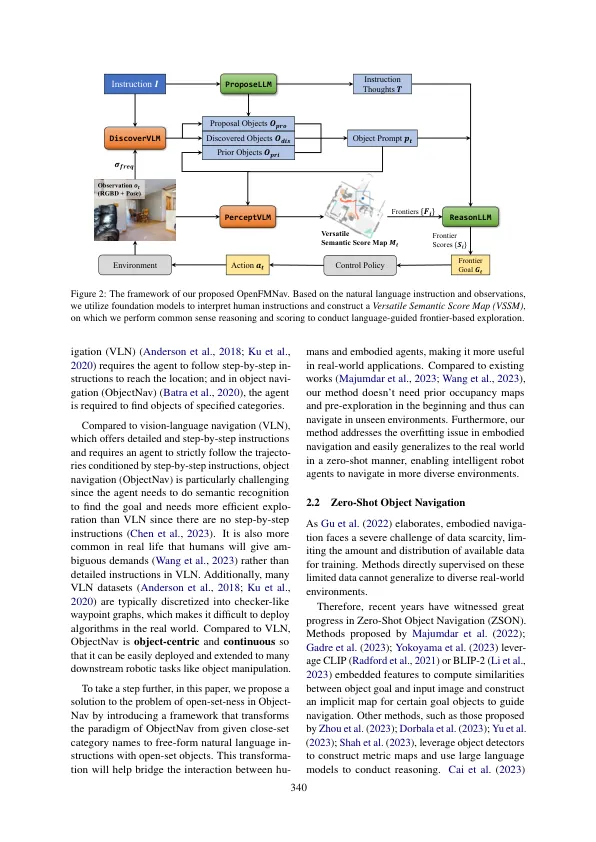

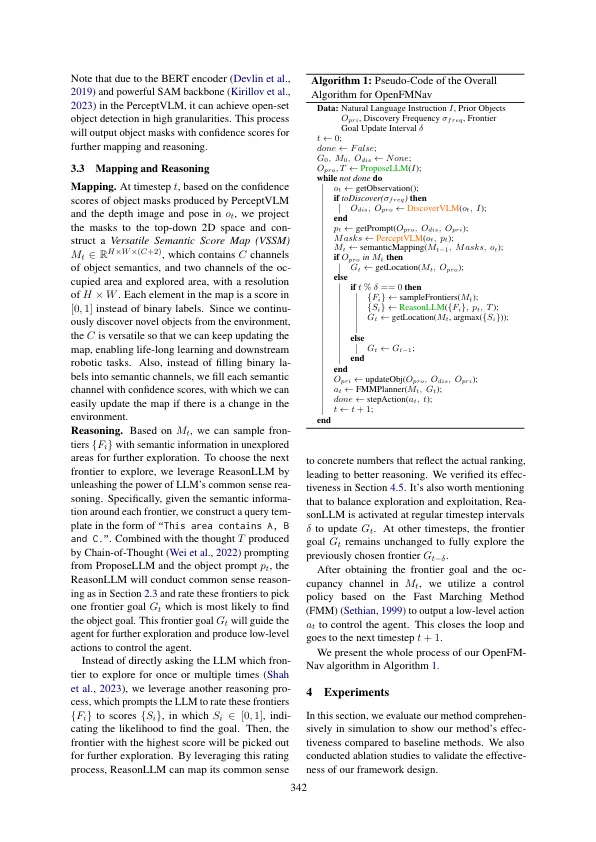

对象导航(ObjectNav)要求代理在看不见的环境中导航以找到查询对象。许多以前的方法试图通过依靠经过跨越或强化学习来解决此任务,在该学习中,它们在具有近距离对象的有限家庭数据集上进行了培训。然而,尚未解决两个主要挑战:了解自由形式的自然语言指令,要求开放式观察,并以零拍的方式推广到新环境。旨在解决这两个挑战,在本文中,我们提出了OpenFM- NAV,这是一个基于零照射对象导航的基于odel m ODEL M ODEL的框架。我们首先释放了大型语言模型(LLMS)的推理能力,以从满足用户需求的自然语言指令中提取拟议的观察。然后,我们利用大型视觉语言模型(VLM)的普遍性来积极地从场景中发现和脱离候选对象,建立多功能语义得分图(VSSM)。然后,通过对VSSM进行常识推理,我们的方法可以对场景进行有效的语言引导探索和剥削,并最终达到目标。通过利用基础模型的推理和概括,我们的方法可以理解自由形式的人类指示并在不同环境中进行有效的开放式零射门导航。在HM3D ObjectNAV基准上进行的广泛实验表明,我们的方法超过了所有指标上的所有强基础,证明了我们方法的有效性。1此外,我们执行真实的机器人演示,以验证我们方法对现实环境的开放定点性和普遍性。

通过Vision-...

主要关键词