机构名称:

¥ 1.0

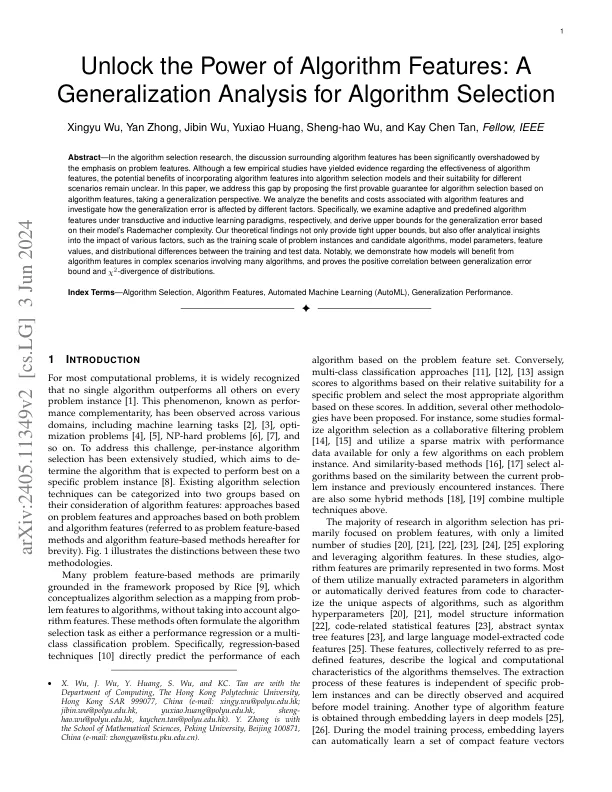

摘要 - 在算法选择研究中,围绕算法特征的讨论被对问题特征的重点显着掩盖了。尽管一些实证研究已经提供了有关算法特征有效性的证据,但是将算法特征纳入算法选择模型的潜在好处,并且对不同场景的适用性尚不清楚。在本文中,我们通过提出基于算法功能的算法选择的第一个可证明的保证来解决这一差距,从而采用概括性的观点。我们分析与算法特征相关的收益和成本,并研究概括误差如何受到不同因素的影响。具体而言,我们分别检查了在转导和感应学习范式下的自适应和预定义算法特征,并根据模型的Rademacher复杂性得出了概括误差的上限。我们的理论发现不仅提供了紧密的上限,而且还提供了有关各种因素的影响的分析见解,例如问题实例的训练量表和候选算法,模型参数,特征值以及培训数据和测试数据之间的分布差异。值得注意的是,我们证明了模型如何从涉及许多算法的复杂场景中受益于算法特征,并证明了分布的概括误差与χ2差异之间的正相关。

算法选择的概括分析

主要关键词