机构名称:

¥ 2.0

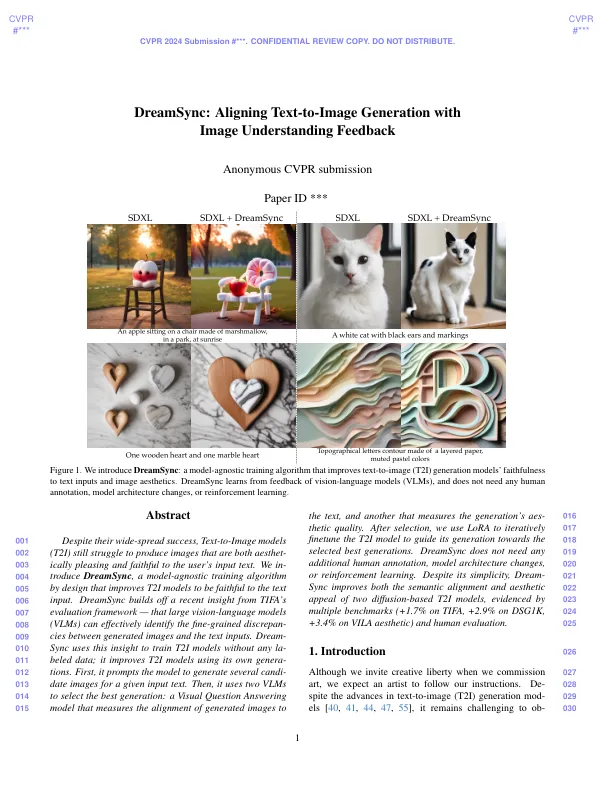

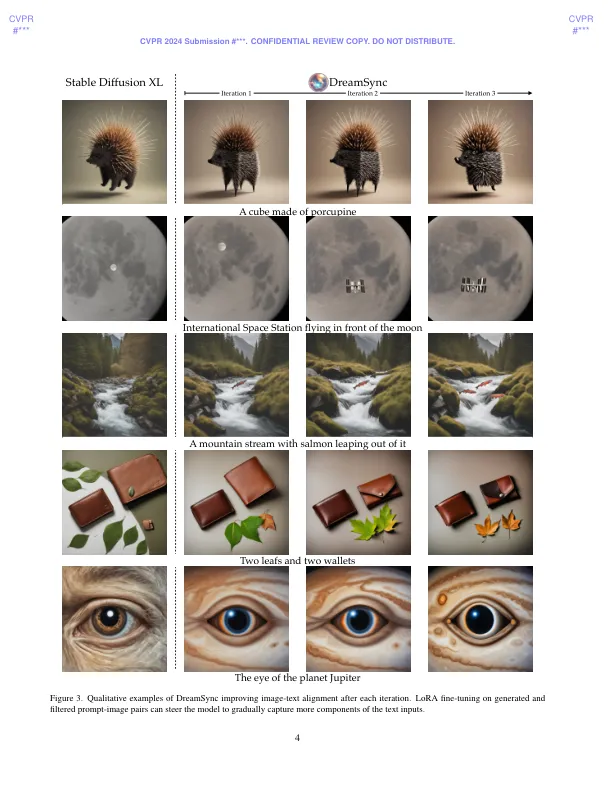

在微调T2I模型上进行对齐方式,但没有重新调整任何人类反馈。Dream-057 Sync背后的关键见解是利用视觉语言mod- 058 ELS(VLMS)的进步,该eLS(VLMS)可以识别生成的图像和用户的输入060文本之间的细粒度差异-059 CIE [7,20]。在高水平上直观地,我们的方法可以将061视为具有人为反馈(RLHF)的强化学习的可扩展版本;正如Llama2 [49] 063使用人类反馈进行了迭代精制一样,DreamSync 064使用VLMS的反馈改善了T2I模型,除了065,而无需加固学习。066给定了一组文本提示,T2i模型首发-067每个提示都有多个候选图像。DreamSync 068使用两个069 VLM自动评估这些生成的图像。第一个测量世代的忠诚070对文本[7,20],而第二个则测量美学071质量[23]。最佳世代被收集并使用072使用参数有效的lora 073 Finetuning [19]。使用新的FineTuned T2I模型,我们重新进行了多个迭代的整个过程:生成IM-075年龄,策划新的填充设置,然后再次进行Finetune。076我们使用最新的基准-077分和人类评估进行广泛的实验。我们使用两个T2I模型SDXL [37]和SD V1.4 [39]实验Dreamsync 078。两种模型的结果079都表明Dreamsync增强了Align-080

dreamsync:将文本到图像的生成对准图像理解反馈

主要关键词