机构名称:

¥ 1.0

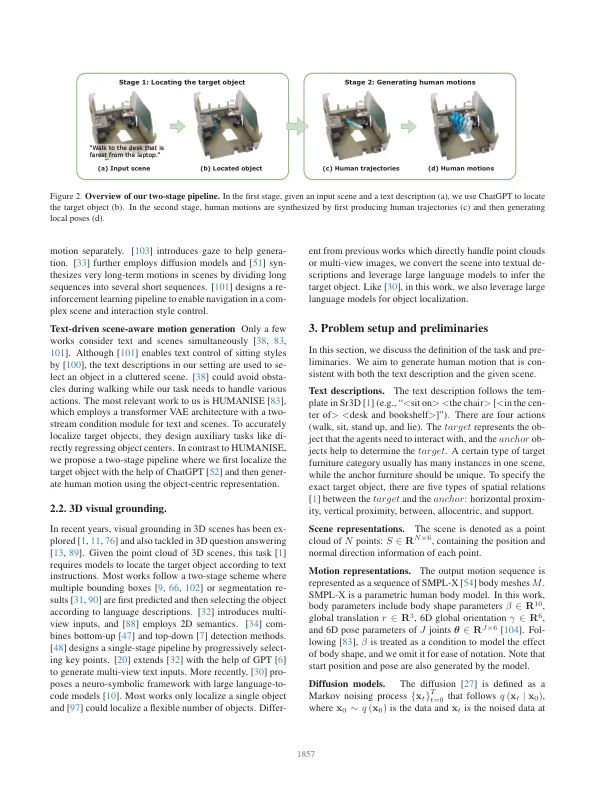

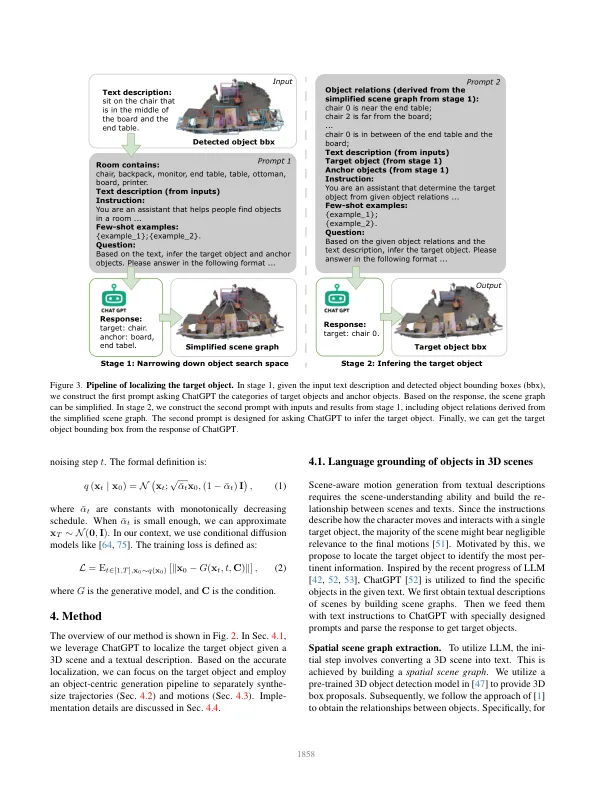

由于其广泛的应用范围,从文本描述中产生人类动作已引起了越来越多的研究兴趣。但是,只有少数作品将人类场景的互动与文本条件一起考虑,这对于视觉和物理现实主义至关重要。本文提出了在3D门场景中产生人类动作的任务,鉴于人类习惯的文本描述。由于文本,场景和运动的多种形式性质以及对空间推理的需求,此任务提出了挑战。为了应对这些挑战,我们提出了一种新方法,将复杂的概率分解为两个更可管理的子问题:(1)目标对象的语言接地和(2)以对象为中心的信息产生。对于目标对象的语言基础,我们利用大型语言模型的力量。对于运动生成,我们设计了一个以对象为中心的场景代表生成模型,以专注于目标对象,从而降低场景的复杂性并促进人类运动与对象之间关系的建模。实验证明了与基准相比,我们的方法的更好运动质量并验证了我们的设计选择。代码将在链接上可用。

从文本说明中生成人类运动

主要关键词