机构名称:

¥ 1.0

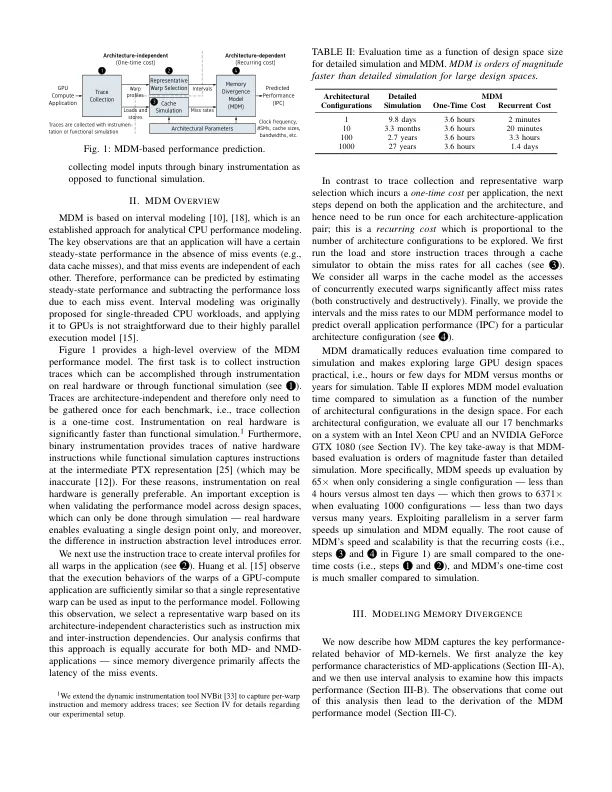

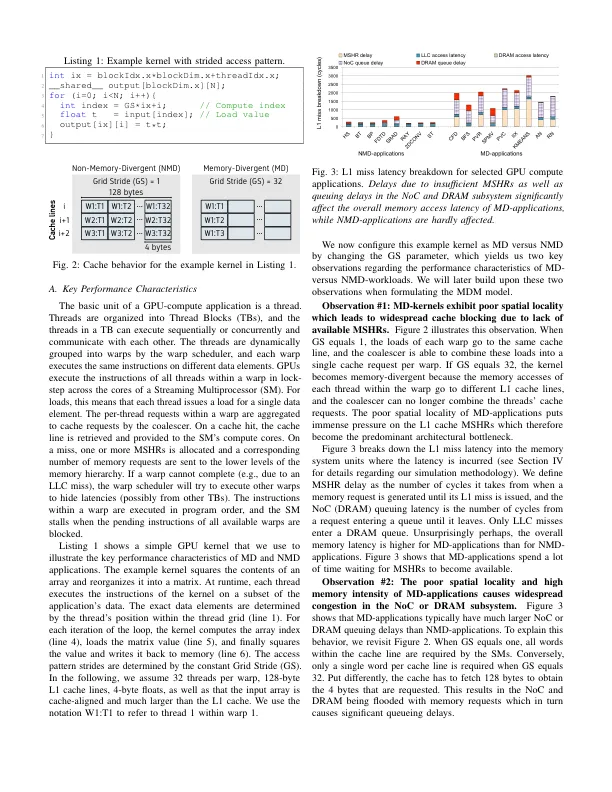

摘要 — 通过使用一组数学方程式捕捉一阶性能现象,分析模型使架构师能够比周期精确模拟快几个数量级地进行早期设计空间探索。但是,如果由于模型不准确而导致通过模型获得的结论具有误导性,则这种速度优势无效。因此,实用的分析模型需要足够准确,以捕捉广泛应用程序和架构配置中的关键性能趋势。在这项工作中,我们专注于分析建模新兴的内存发散 GPU 计算应用程序的性能,这些应用程序在机器学习和数据分析等领域很常见。这些应用程序的空间局部性较差,导致 L1 缓存频繁阻塞,因为应用程序发出的并发缓存未命中数量远远超过缓存可以支持的次数,从而削弱了 GPU 使用线程级并行 (TLP) 隐藏内存延迟的能力。我们提出了 GPU 内存发散模型 (MDM),该模型忠实地捕捉了内存发散应用程序的关键性能特征,包括内存请求批处理和过多的 NoC/DRAM 排队延迟。我们根据详细的模拟和真实硬件验证了 MDM,并报告了以下方面的重大改进:(1) 范围:除了非内存发散应用程序外,还能够对流行的内存发散应用程序进行建模;(2) 实用性:通过使用二进制插装而不是功能模拟来计算模型输入,速度提高了 6.1 倍;(3) 准确性:平均预测误差为 13.9%,而最先进的 GPUMech 模型为 162%。

MDM:GPU 内存发散模型

主要关键词