机构名称:

¥ 1.0

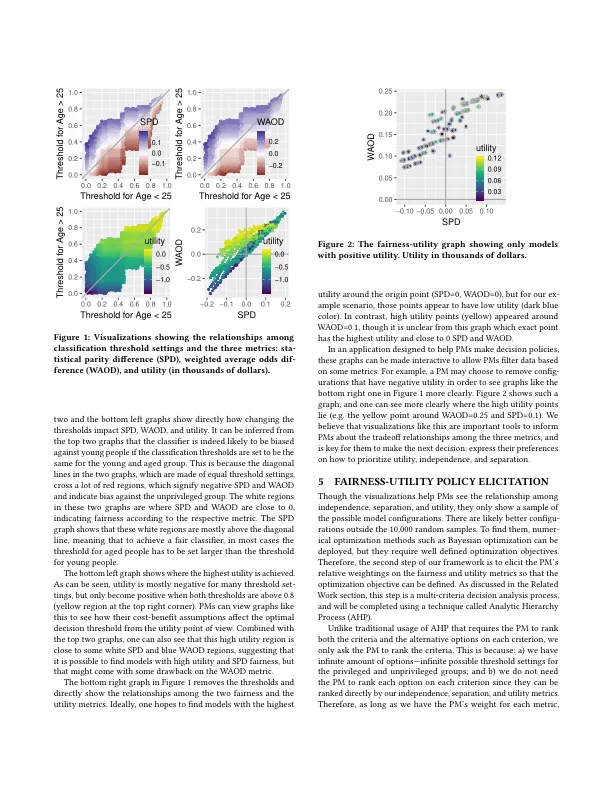

如今,人工智能越来越多地被用于许多高风险决策应用中,其中公平性是一个重要问题。目前,已经有许多人工智能存在偏见并做出可疑和不公平决策的例子。人工智能研究界提出了许多方法来衡量和减轻不必要的偏见,但其中很少有方法涉及人类决策者的意见。我们认为,由于不同的公平标准有时无法同时满足,并且实现公平通常需要牺牲模型准确性等其他目标,因此,关键是要了解并遵守人类决策者关于如何在这些目标之间进行权衡的偏好。在本文中,我们提出了一个框架和一些示例方法来引出这些偏好并根据这些偏好优化人工智能模型。

人工智能公平性与效用的联合优化