机构名称:

¥ 1.0

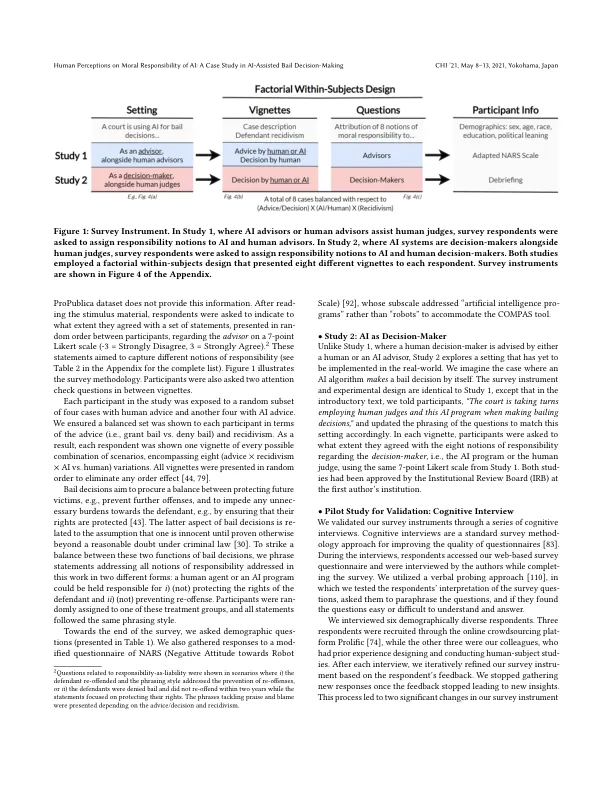

如何为自主人工智能 (AI) 系统的行为归责一直是人文和社会科学领域的广泛争论话题。这项研究提出了两个实验(每个实验 𝑁 =200),测量人们对保释决策背景下有关人工智能和人类代理的八种不同道德责任观念的看法。使用现实生活中的改编场景,我们的实验表明,对于相同的任务,人工智能代理与人类代理一样要承担因果责任并受到类似的指责。然而,人们对这些代理的道德责任的看法存在显著差异;与人工智能代理相比,人类代理被赋予了更高程度的当前和前瞻性责任观念。我们还发现,无论决策性质如何,人们都期望人工智能和人类决策者和顾问能够证明他们的决策是合理的。我们讨论了这些发现对政策和人机交互的影响,例如在高风险场景中需要可解释的人工智能。

人工智能辅助保释决策案例研究