机构名称:

¥ 1.0

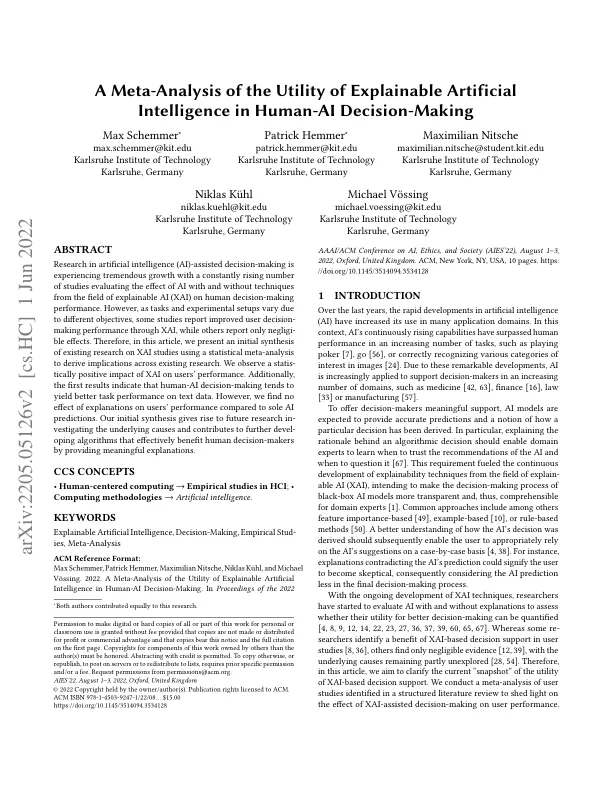

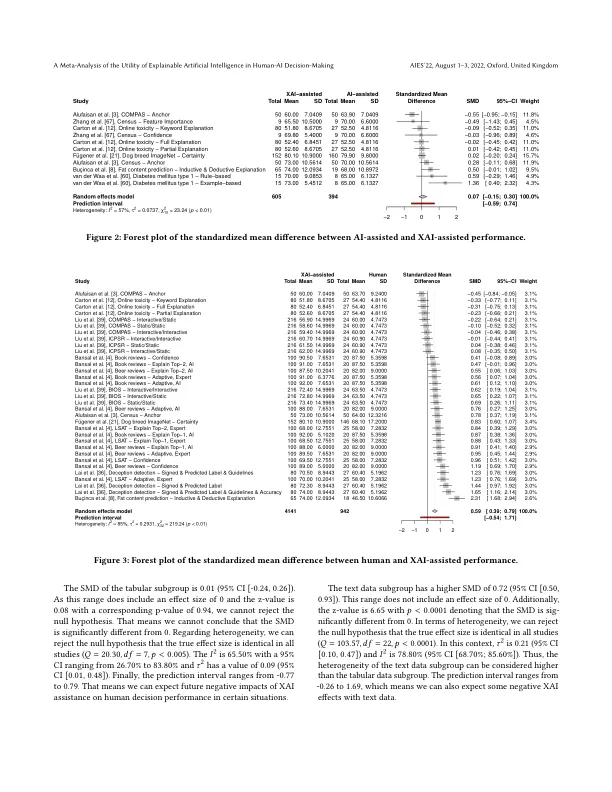

人工智能 (AI) 辅助决策的研究正在经历巨大的增长,越来越多的研究评估了使用和不使用可解释人工智能 (XAI) 领域的技术对人类决策表现的影响。然而,由于任务和实验设置因目标不同而不同,一些研究报告称通过 XAI 提高了用户的决策表现,而另一些研究报告称影响微乎其微。因此,在本文中,我们使用统计荟萃分析对现有 XAI 研究进行了初步综合,以得出现有研究的启示。我们观察到 XAI 对用户表现有统计上的积极影响。此外,第一批结果表明,人机决策往往会在文本数据上产生更好的任务表现。然而,与单一的人工智能预测相比,我们发现解释对用户的表现没有影响。我们的初步综合引发了未来研究调查根本原因,并有助于进一步开发通过提供有意义的解释有效造福人类决策者的算法。

可解释人工智能在人机决策中的效用的元分析