机构名称:

¥ 1.0

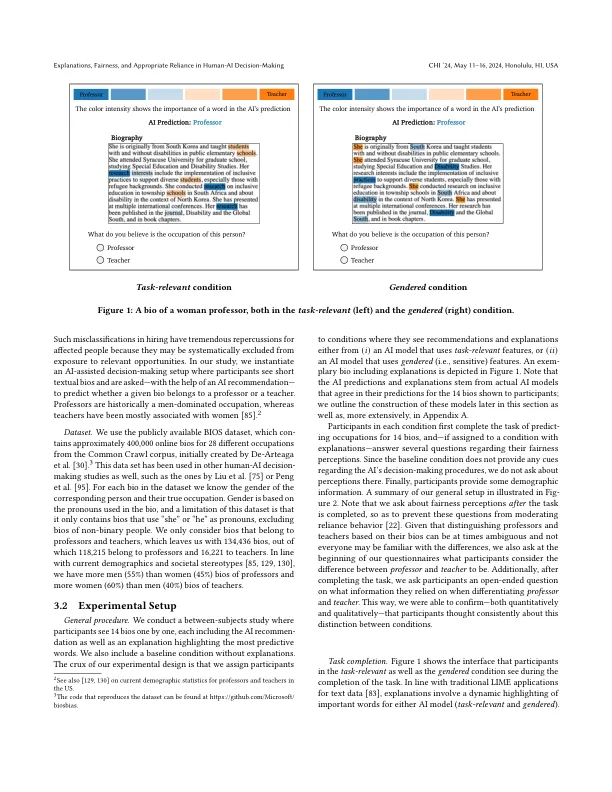

在这项工作中,我们研究了基于特征的解释对人工智能辅助决策分配公平性的影响,特别关注从简短的文本简历中预测职业的任务。我们还研究了任何影响是如何通过人类的公平感知及其对人工智能建议的依赖来调节的。我们的研究结果表明,解释会影响公平感知,而公平感知又与人类遵守人工智能建议的倾向有关。然而,我们发现这样的解释并不能让人类辨别正确和不正确的人工智能建议。相反,我们表明,无论人工智能建议的正确性如何,它们都可能影响依赖性。根据解释强调的特征,这可能会促进或阻碍分配公平:当解释强调与任务无关且显然与敏感属性相关的特征时,这会提示覆盖与性别刻板印象相符的 AI 建议。同时,如果解释看起来与任务相关,这会引发依赖行为,从而强化刻板印象一致的错误。这些结果表明基于特征的解释不是提高分配公平性的可靠机制。

人机决策中的解释、公平性和适当依赖

主要关键词