机构名称:

¥ 1.0

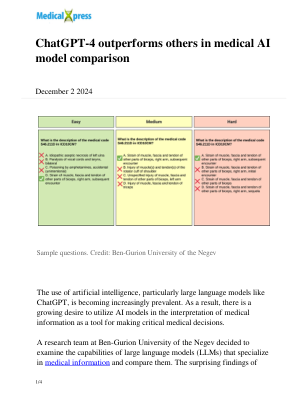

大型生成式人工智能模型 (LGAIM),例如 ChatGPT、GPT-4 或 Stable Diffusion,正在迅速改变我们交流、说明和创造的方式。然而,欧盟及其他地区的人工智能监管主要侧重于传统人工智能模型,而非 LGAIM。本文将这些新的生成式模型置于当前关于可信人工智能监管的辩论中,并探讨如何根据其能力量身定制法律。在奠定技术基础之后,本文的法律部分分为四个步骤,涵盖 (1) 直接监管、(2) 数据保护、(3) 内容审核和 (4) 政策建议。它提出了一种新颖的术语,通过区分 LGAIM 开发人员、部署人员、专业和非专业用户以及 LGAIM 输出的接收者来捕捉 LGAIM 环境中的人工智能价值链。我们根据价值链上的不同参与者量身定制监管职责,并提出策略以确保 LGAIM 值得信赖并部署以造福整个社会。 《人工智能法案》和其他直接监管中的规则必须与预训练模型的特性相匹配。本文主张对 LGAIM 施加三层义务(所有 LGAIM 的最低标准、高风险用例的高风险义务、沿着人工智能价值链的协作)。一般而言,监管应侧重于具体的高风险应用,而不是预训练模型本身,并且应包括(i)有关透明度的义务和(ii)风险管理。不过,非歧视条款(iii)可能适用于 LGAIM 开发者。最后,(iv)DSA 内容审核规则的核心应扩大到涵盖 LGAIM。这包括通知和行动机制以及值得信赖的举报人。

监管 ChatGPT 和其他大型生成式 AI 模型

主要关键词