机构名称:

¥ 1.0

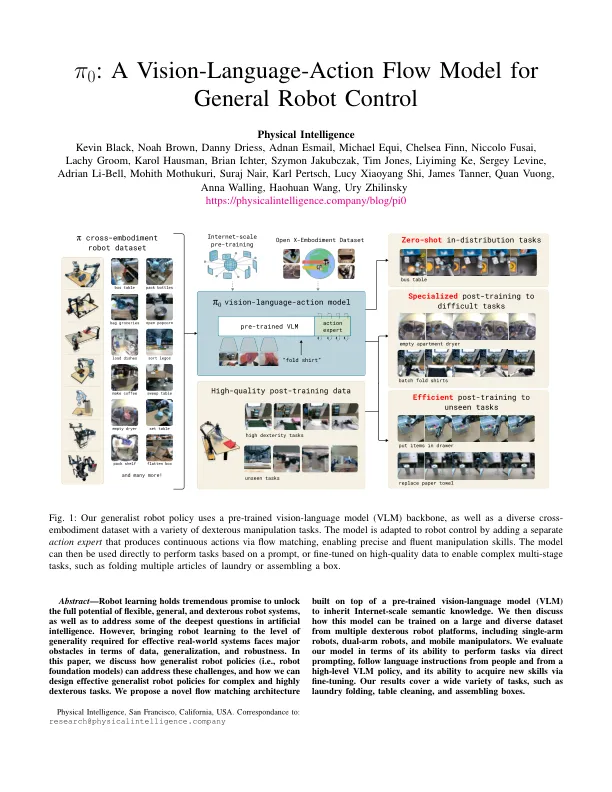

人工智能系统的形式和规模各有不同,有高度专业化的系统可以解决人类思维无法解决的复杂问题,比如预测蛋白质的构象 [ 21 ],也有可以根据文本提示生成逼真的高分辨率图像或视频的系统 [ 40 ]。然而,人类智能超越机器智能的最大优势是多功能性:能够解决不同物理环境中的不同任务,同时对环境约束、语言命令和意外干扰做出智能响应。人工智能在实现这种多功能性方面最实质性的进展或许体现在大型语言和视觉语言模型 [ 1, 48 ] 中:这些系统先在网络上的大量且非常多样化的图像和文本语料库上进行预训练,然后使用更精心策划的数据集进行微调(“对齐”),以诱导所需的行为和响应模式。虽然这些模型已被证明具有广泛的指令遵循和解决问题的能力 [ 53 , 27 ],但它们并不像人类那样真正地存在于物理世界中,它们对物理交互的理解完全基于抽象描述。如果这些方法要在人工智能系统方面取得切实进展,使其表现出人类所拥有的那种物理情境多功能性,我们将需要使用物理情境数据(即来自具身机器人代理的数据)对它们进行训练。灵活的通用模型可以执行各种机器人行为,具有巨大的实际意义,但它们也可能为当今机器人学习面临的一些最严峻的挑战提供解决方案,例如数据的可用性、泛化和鲁棒性。在自然语言 [ 1 ] 和计算机视觉 [ 39 ] 中,在各种多任务数据上预先训练的通用基础模型往往优于狭义的和专门的模型

π0:视觉-语言-动作流模型

主要关键词