机构名称:

¥ 1.0

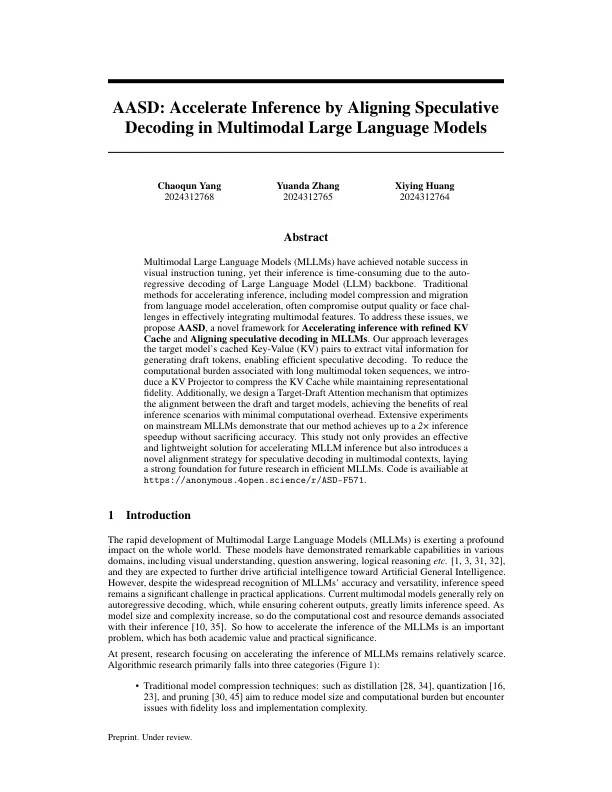

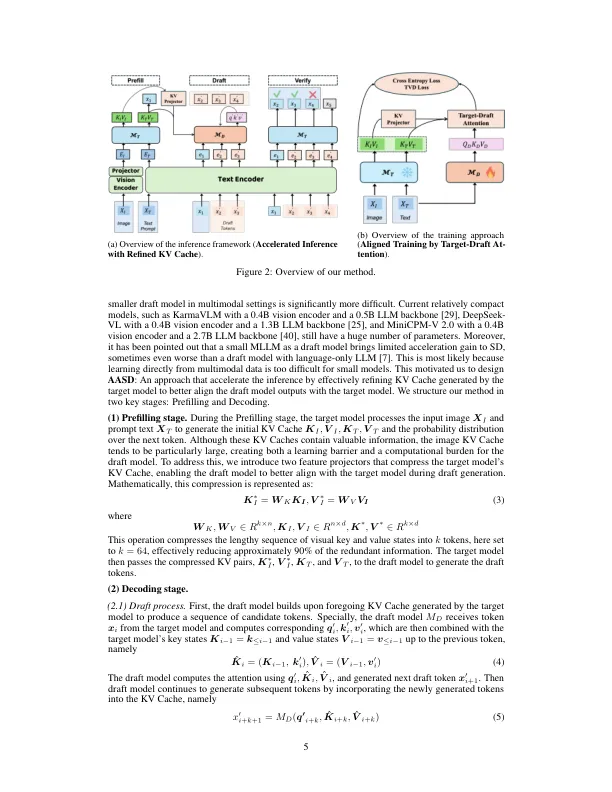

多模式大型语言模型(MLLM)在视觉教学调整中取得了显着的成功,但由于大型语言模型(LLM)骨干的自动回归解码,它们的推论既耗时又耗时。传统的加速推理方法,包括模型压缩和从语言模型加速的迁移,通常会损害输出质量或有效整合多模式特征的face Challenges。为了解决这些问题,我们提出了AASD,这是一个新型的框架,用于加速使用精制的KV缓存并在MLLM中对准投机解码。我们的方法利用目标模型的缓存键值(KV)对提取生成草稿令牌的重要信息,从而有效地投机解码。为了减少与长多模式令牌序列相关的计算负担,我们会引入KV投影仪,以压缩KV缓存,同时保持代表性保真度。此外,我们设计了一种目标放射线注意机制,以优化草稿和目标模型之间的对齐方式,从而以最小的计算开销来实现真实推理情景的好处。主流MLLM的广泛实验表明,我们的方法在不牺牲准确性的情况下达到了2倍推理的速度。这项研究不仅为加速MLLM推断提供了有效且轻巧的解决方案,而且还引入了一种新颖的对齐策略,用于在多模式背景下进行投机解码,从而为未来的有效MLLM研究奠定了强大的基础。代码可在https://anonymon.4open.science/r/asd-f571上使用。

AASD:通过在多模式大型语言模型中对准投机解码来加速推理

主要关键词