机构名称:

¥ 1.0

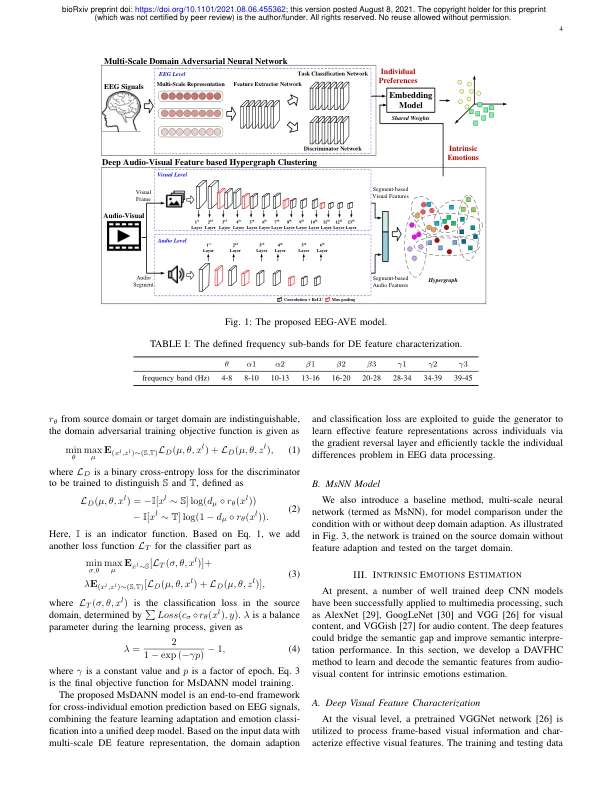

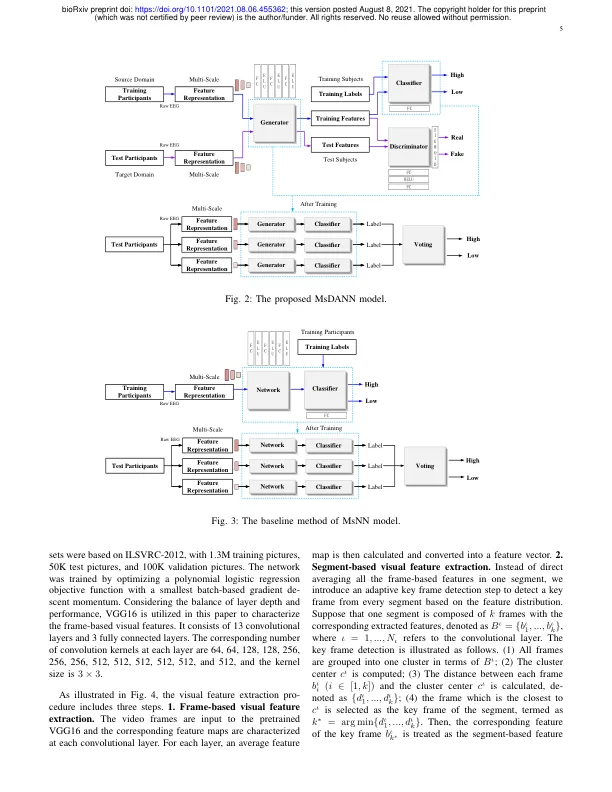

摘要 - EEG信号已成功地用于情感检测应用中,可以直接捕获大脑动态并以高时间分辨率反映情绪变化。但是,跨个体模型的广义能力尚未得到彻底发展。其他数据模式的参与,例如用于触发情绪的音频信息,可能是有益的,可以估计视频内容中的内在情绪并解决个体差异问题。在本文中,我们提出了一种新颖的深度情感检测模型,称为脑电图,带有视听嵌入(EEG-ave),用于跨个体情感检测。在这里,EEG信号被利用以识别个性化模式并在情感检测中贡献个人偏好;虽然利用视听信息来估算视频内容中涉及的内在情绪,并提高了情感检测性能的可靠性。为基于EEG的个体偏好预测,开发了多尺度域对抗性神经网络,以探索个人跨个体的共享动态,信息性和域不变的EEG特征。为基于视频的固有情绪估计,采用了基于视听功能的深度视听群集方法,以检查语义音频视觉特征和情感之间的潜在关系。通过嵌入模型,估计的个体偏好和内在情绪都与共同的权重结合在一起,并进一步用于共同有助于跨个体的情感检测。我们对Mahnob-HCI数据库进行了跨个体情感检测实验,以进行模型评估和比较。结果表明,我们提出的EEG-ave模型在剩余的一个个体分离的交叉验证个人独立的评估方案下取得了更好的性能,使用汇总标签的价格为90.21%,价值为90.21%和85.59%,并使用汇总标签,以及使用价值为71.13%和66.47%,用于价值和66.47%。因此,EEG-ave是一个具有良好通用性的有效模型,它使其成为现实应用中跨个体情绪检测的力量工具。

使用带有音频嵌入

主要关键词