机构名称:

¥ 1.0

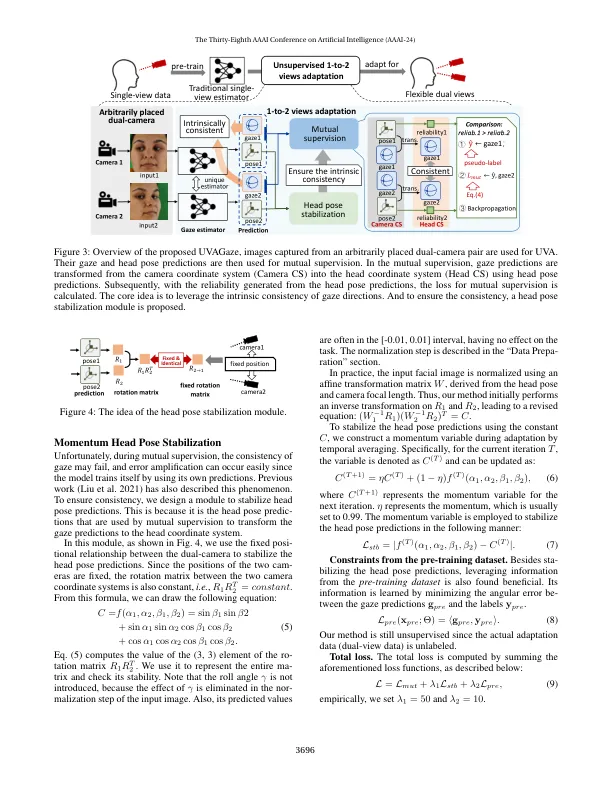

目光的估计已成为最近研究日益兴趣的主题。大多数当前方法都依赖于单视面图像作为输入。然而,这些副本很难处理较大的头部角度,从而导致估计的准确性。要解决此问题,添加二视摄像头可以帮助更好地捕获眼睛的外观。但是,现有的多视图方法具有两个限制。1)他们需要培训的多视图注释,这很昂贵。2)更重要的是,在测试过程中,必须知道多个相机的确切位置并与训练中使用的相匹配,这限制了应用程序场景。为了应对这些挑战,我们提出了一种新颖的1视图 - 2视图(1-2视图)适应解决方案,在本文中,无监督的1-2视图适应框架 - 用于注视估计的工作(UVagaze)。我们的方法适应了一个传统的单视凝视估计器,以灵活地放置了双摄像头。在这里,“灵活”意味着我们将双摄像头放在任意位置,而不论训练数据如何,而不知道它们的外部参数。具体来说,乌瓦加兹(Uvagaze)建立了双视图相互监督适应策略,它利用了两种观点之间的凝视方向的内在一致性。以这种方式,我们的方法不仅可以从常见的单视图预训练中受益,而且还可以实现更高级的双视凝视估计。实验结果表明,单视图估计量适用于双重视图,可以获得更高的效果,尤其是在跨数据集设置中,取代率提高了47.0%。项目页面:https://github.com/ mickeyllg/uvagaze。

无监督的1-2视图适应凝视估计

主要关键词