机构名称:

¥ 1.0

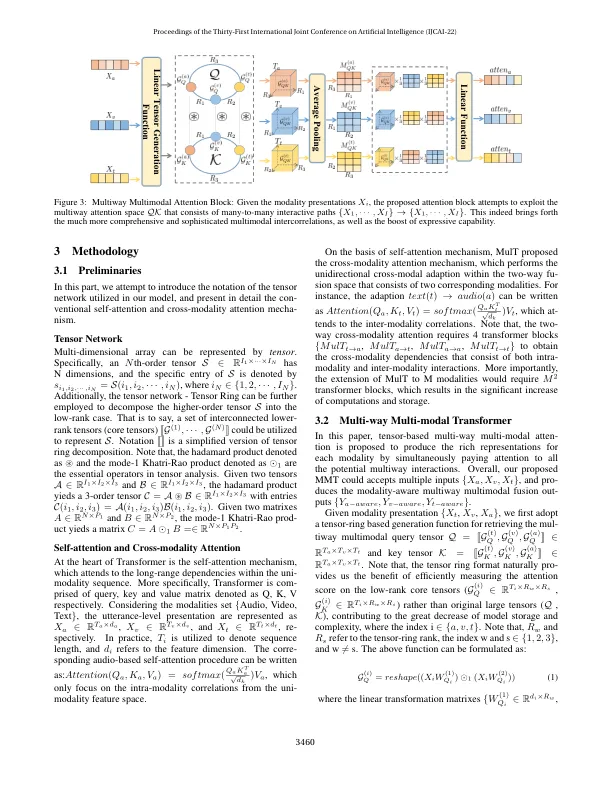

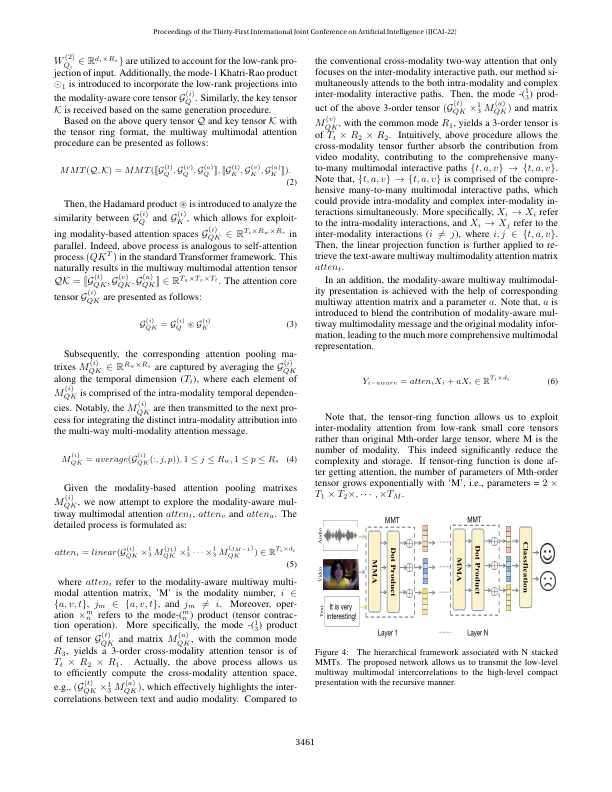

多模态学习研究的核心在于有效利用多模态之间的融合表示。然而,现有的双向跨模态单向注意力只能利用从一个源到一个目标模态的模态间相互作用。在模态数量有限且交互方向固定的情况下,这确实无法释放多模态融合的全部表达能力。在本文中,提出了多路多模态变换器(MMT),通过单个块而不是多个堆叠的跨模态块同时探索每个模态的多路多模态互相关。MMT 的核心思想是多路多模态注意力,其中利用多种模态来计算多路注意张量。这自然有利于我们开发全面的多对多多模态交互路径。具体而言,多路张量由多个相互连接的模态感知核心张量组成,这些核心张量由模态内交互组成。此外,张量收缩操作用于研究不同核心张量之间的模态间依赖关系。本质上,我们基于张量的多路结构允许将 MMT 轻松扩展到与任意数量的模态相关的情况。以 MMT 为基础,进一步建立分层网络,以递归方式将低级多路多模态交互传输到高级交互。实验表明,MMT 可以实现最先进或相当的性能。

用于多模态学习的多路多模态 Transformer

主要关键词