机构名称:

¥ 1.0

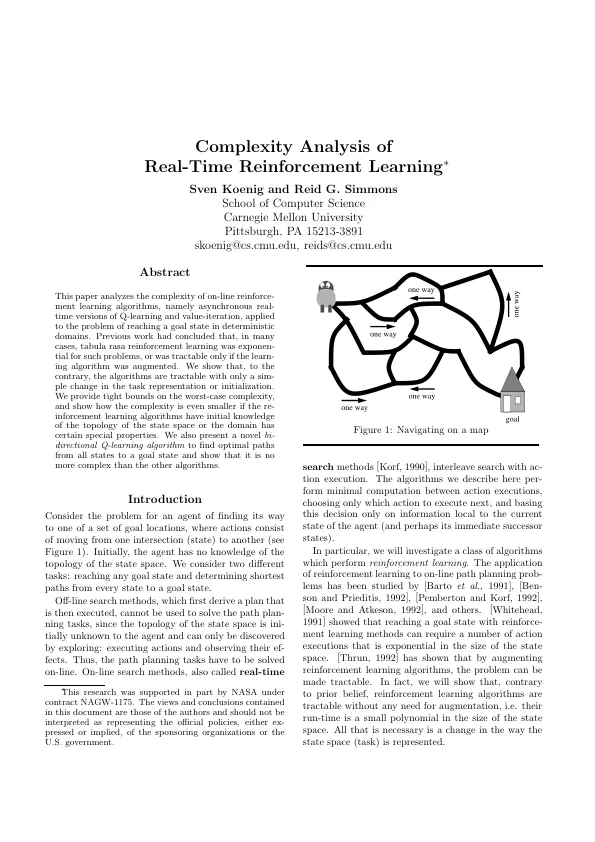

本文分析了在线增强学习算法的复杂性,即Q学习和价值意识的异步实时版本,应用于确定性域中达到目标状态的问题。先前的工作得出的结论是,在许多情况下,Tabula Rasa强化学习是针对此类问题的指定的,或者只有在增强学习算法时才可以处理。我们表明,相反,算法是可以处理的,而任务表示或初始化的模拟更改。我们在最坏情况的复杂性上提供了紧密的界限,并显示出复杂性是如何较小的,如果系统性学习算法对状态空间或域具有某些特殊属性的初始了解。我们还提出了一种新颖的双向Q学习算法,以从所有状态到目标状态找到最佳路径,并表明它不比其他算法更复杂。

实时强化学习的复杂性分析