机构名称:

¥ 1.0

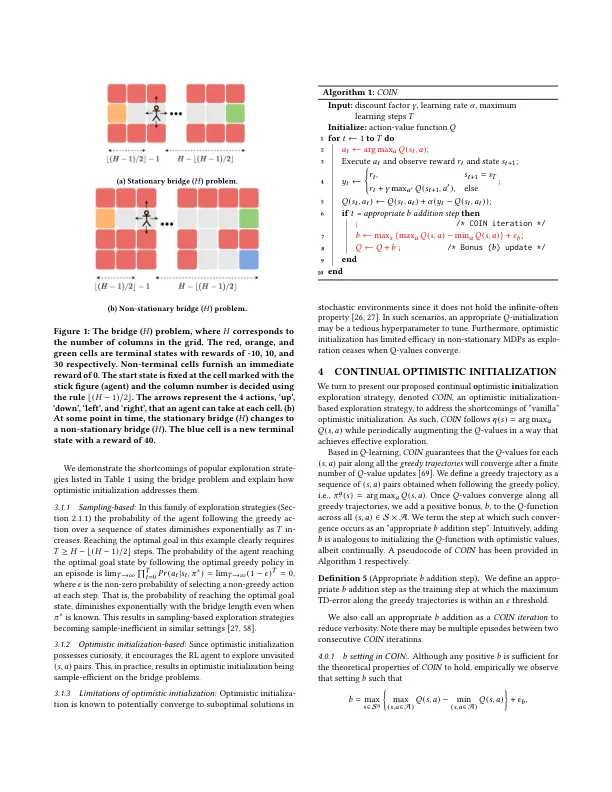

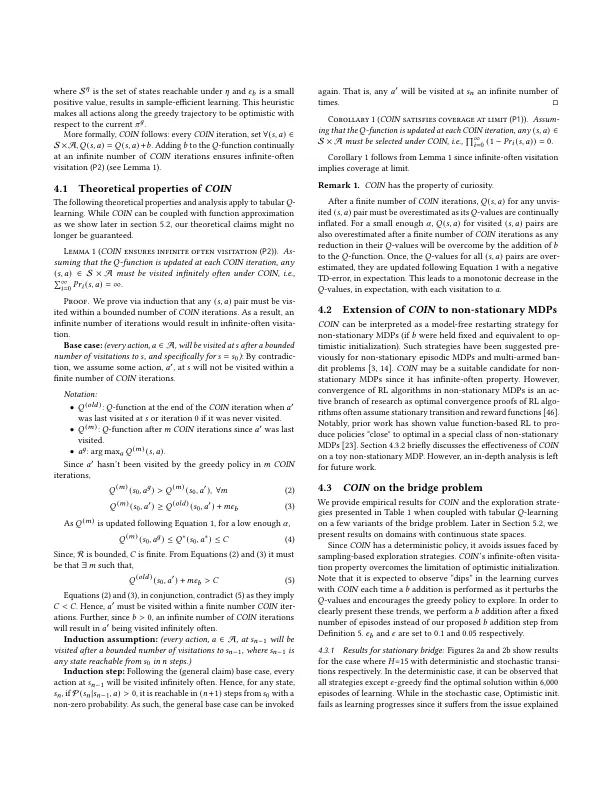

全面的国家行动探索对于加强学习(RL)算法至关重要。它使他们能够找到最佳解决方案并避免过早收敛。在基于价值的RL中,对价值函数的乐观初始化可确保足够的研究以找到最佳解决方案。乐观的值会导致好奇心驱动的探索,从而实现了未经探索的区域的访问。然而,乐观的初始化由于无法探索“无限易用”的探索,因此在恶化和非平稳环境中存在局限性。为了解决这一限制,我们提出了基于反复出现的乐观初始化的基于价值的RL的新型探索策略,表示硬币。通过注入持续的探索奖金,我们克服了乐观的不隔离(对环境噪声的敏感性)的缺点。我们提供了硬币与现有流行探索策略的严格理论比较,并证明它提供了一套独特的属性(覆盖范围,无限,通常不访问跟踪和好奇心)。我们揭示了硬币比普遍的玩具域上的现有策略的优越性,并在常见的基准任务上呈现结果。我们观察到,在六个基准任务中的四个中,硬币的表现优于现有的探索策略,同时与其他两个任务的最佳基线表现出色。

基于价值的强化学习的持续乐观初始化

主要关键词