机构名称:

¥ 1.0

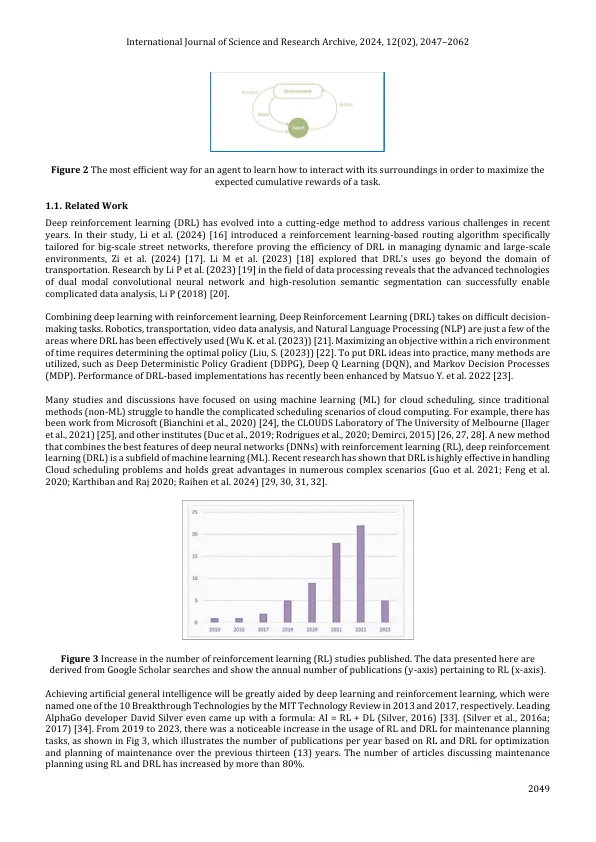

本文介绍了在增强学习领域(RL)中传统Q学习(QL)和深Q学习(DQL)的独特机制和应用。传统的Q学习(QL)利用Bellman方程来更新存储在Q桌上的Q值,从而适合简单环境。但是,由于国家行动对在复杂环境中的指数增长,其可伸缩性受到限制。深Q学习(DQL)通过使用神经网络近似Q值来解决此限制,从而消除了对Q-table的需求,并可以有效地处理复杂环境。神经网络(NN)充当代理商的决策大脑,学会通过训练来预测Q值,并根据收到的奖励调整其权重。该研究强调了良好的奖励系统在增强学习中的重要性(RL)。适当的奖励结构指导代理人采取所需的行为,同时最大程度地减少意外行动。通过同时运行多个环境,训练过程得到了加速,使代理商可以收集各种体验并有效地提高其性能。对培训模型的比较分析表明,平衡良好的奖励系统会导致更加一致和有效的学习。调查结果强调了在增强学习系统中仔细设计的必要性,以确保在简单和复杂的环境中确保最佳的代理行为和有效的学习成果。通过这项研究,我们获得了对Q学习(QL)和深度Q学习(DQL)应用的宝贵见解,从而增强了我们对代理方式学习和适应其环境的理解。

使用神经网络在复杂环境中优化加强学习

主要关键词