机构名称:

¥ 1.0

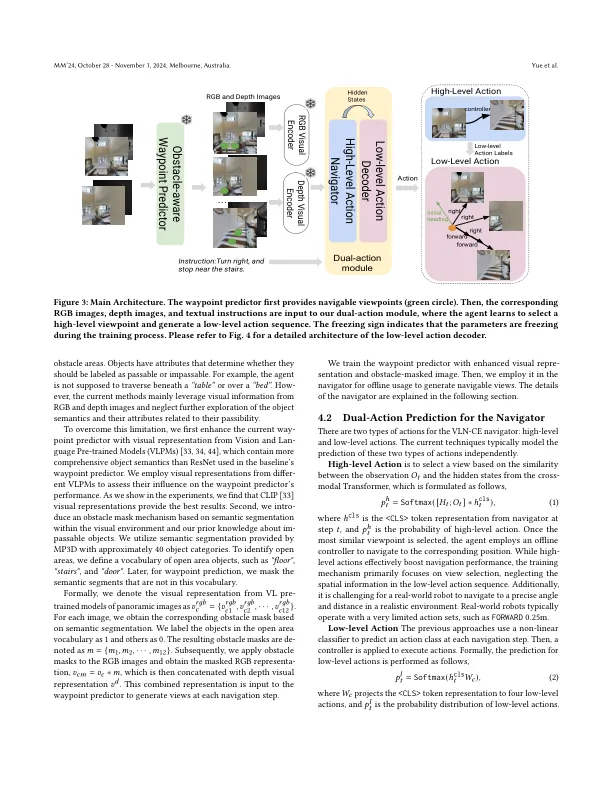

连续环境(VLN-CE)中的视觉和语言导航的现有方法通常结合了离散环境的方法预测指标。与使用低级操作的直接训练相比,这将导航操作简化为视图选择任务,并显着提高导航性能。但是,VLN-CE代理仍然远离真正的机器人,因为它们的视觉感知和执行动作之间存在差距。首先,离散视觉环境的VLN-CE代理主要是通过高级视图选择训练的,这使他们忽略了低级动作运动中关键的空间推理。第二,在这些模型中,现有的Waypoint预测因素忽略了对象语义及其与可传递性有关的属性,这在指示动作的可行性时可能会提供信息。为了解决这两个问题,我们引入了一个低级动作解码器,该解码器联合训练了具有高级动作预测,使当前的VLN代理可以学习并将所选的视觉视图扎根至低级控制。此外,我们通过利用包含丰富语义信息并根据人类对行动可行性的先验知识明确掩盖障碍来增强当前的路点预测指标。从经验上讲,与高级和低级作用的强基础相比,我们的代理可以改善导航性能指标。

缩小导航中的视力与动作之间的差距

主要关键词