机构名称:

¥ 1.0

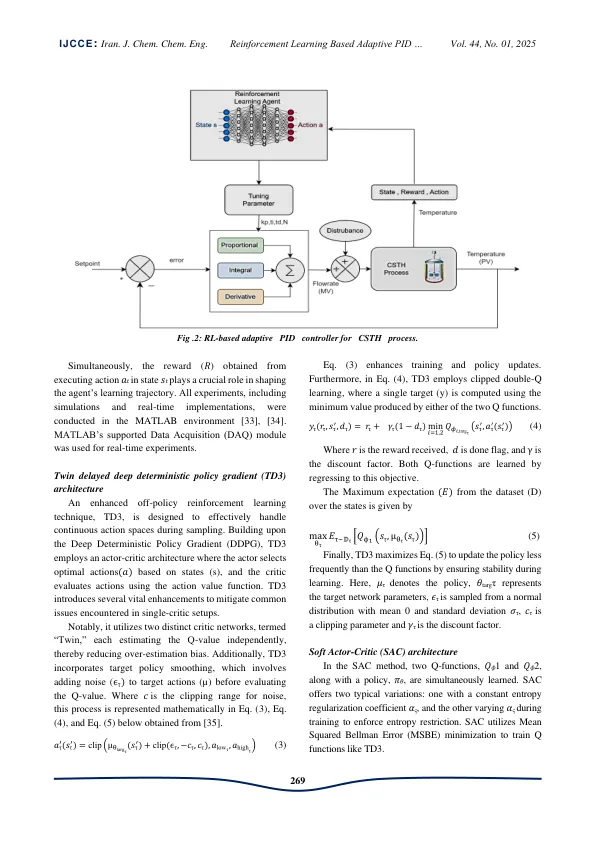

由于需要线性化非线性系统,传统控制器的应用仅限于非线性过程的实时分析。此外,调整提出了一个重大挑战,尤其是在处理非线性系统时,因为传统方法通常需要复杂的手动计算才能在各种约束下进行操作。该研究所考虑的连续搅拌坦克加热器(CSTH)过程具有广泛的工作点,并且高度非线性。因此,这项研究的目的是通过利用强化学习(RL)来简化传统比例积分衍生物(PID)控制器调整过程,并适应实时动态过程需求,以简化传统的比例积分衍生物(PID)控制器调整过程。该研究主要关注CSTH过程的温度控制,该过程以其非线性和时间延迟特征而闻名。通过采用基于策略的RL技术,特别是双胞胎延迟的深层确定性政策(TD3)和软批评者(SAC)RL具有适当的奖励功能,调查评估了其对各种设定点的适应性,并具有抗扰动性。通过严格的实验和分析,观察到具有高斯奖励功能的TD3与SAC相比表现良好。这项研究试图证明基于TD3 RL的方法的性能在简化PID调整中的性能通过降低诸如ISE,IAE,IAE,SATTLING时间和过冲的绩效指标,为47.6%,26.5%,3.8%,3.8%和100%用于伺服响应,ISE和ISE和定居时间为37.7%和4.7%的人,而PIDER的响应者则是指数。

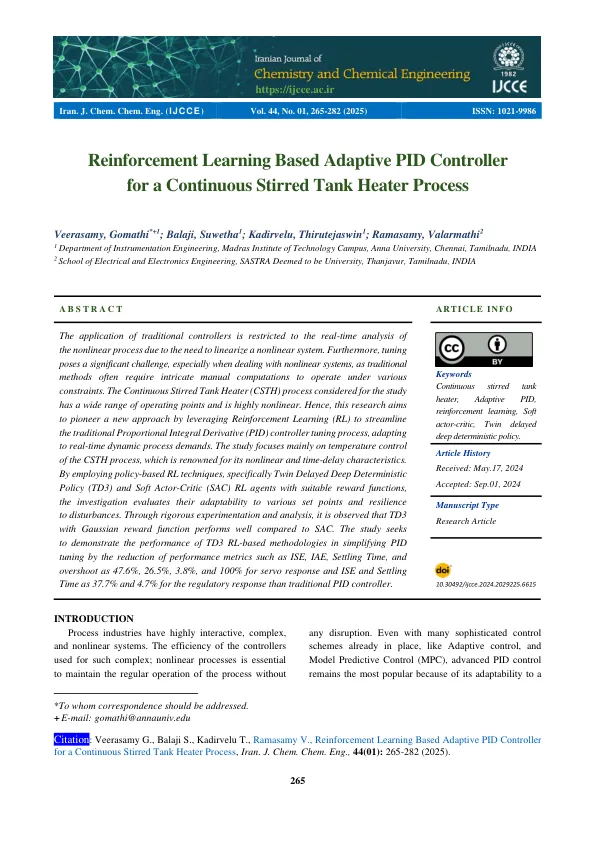

基于...

主要关键词