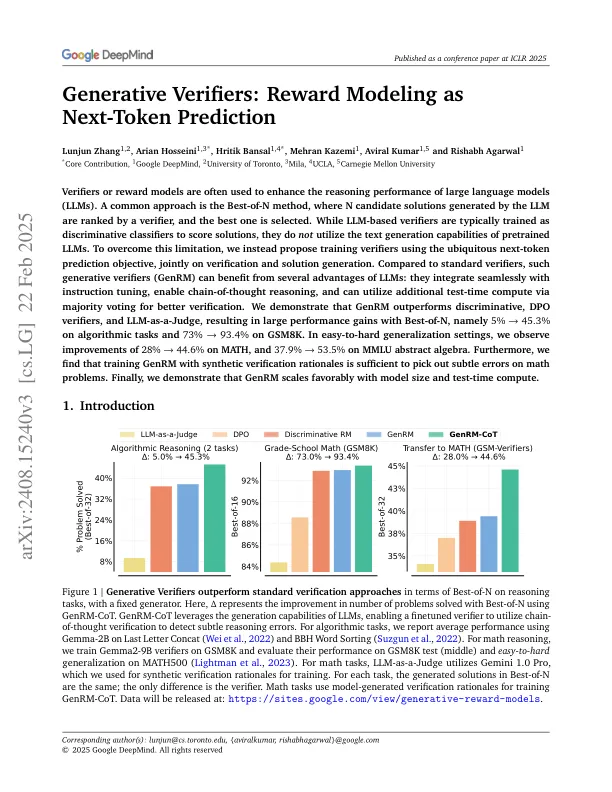

验证者或奖励模型通常用于增强大语言模型(LLM)的推理性能。一种常见的方法是最好的N方法,其中LLM生成的N候选解决方案由验证者排名,并且选择了最好的解决方案。基于LLM的验证者通常被培训为判别性分类器以评分解决方案,但它们并未利用验证的LLM的文本生成能力。为了克服这一限制,我们使用无处不在的下一步预测目标提出了培训验证仪,共同核对和解决方案生成。与标准验证符相比,这种生成验证符(GENRM)可以从LLM的几个优点中受益:它们与指导调整无缝集成,启用了经过思考的推理,并且可以通过多数投票利用额外的测试时间计算来获得更好的验证。我们证明GENRM的表现优于歧视性,DPO验证者和LLM-AS-A-a-gudge,导致了最佳N的性能增长,即5%→45。算法任务的3%和73%→93。GSM8K的4%。 在易于硬化的概括设置中,我们观察到28%→44的改善。 数学的6%,37。 9%→53。 MMLU摘要代数为5%。 此外,我们发现具有合成验证原理的训练GENRM足以在数学问题上发现微妙的错误。 最后,我们证明GENRM会以模型大小和测试时间计算来表现出色。GSM8K的4%。在易于硬化的概括设置中,我们观察到28%→44的改善。数学的6%,37。 9%→53。 MMLU摘要代数为5%。 此外,我们发现具有合成验证原理的训练GENRM足以在数学问题上发现微妙的错误。 最后,我们证明GENRM会以模型大小和测试时间计算来表现出色。数学的6%,37。9%→53。MMLU摘要代数为5%。 此外,我们发现具有合成验证原理的训练GENRM足以在数学问题上发现微妙的错误。 最后,我们证明GENRM会以模型大小和测试时间计算来表现出色。MMLU摘要代数为5%。此外,我们发现具有合成验证原理的训练GENRM足以在数学问题上发现微妙的错误。最后,我们证明GENRM会以模型大小和测试时间计算来表现出色。

生成验证者:作为下一句话预测的奖励建模