机构名称:

¥ 1.0

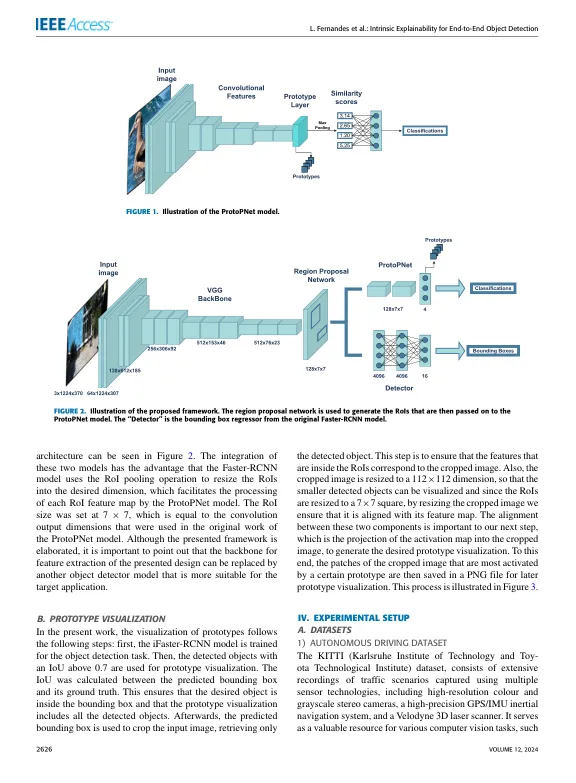

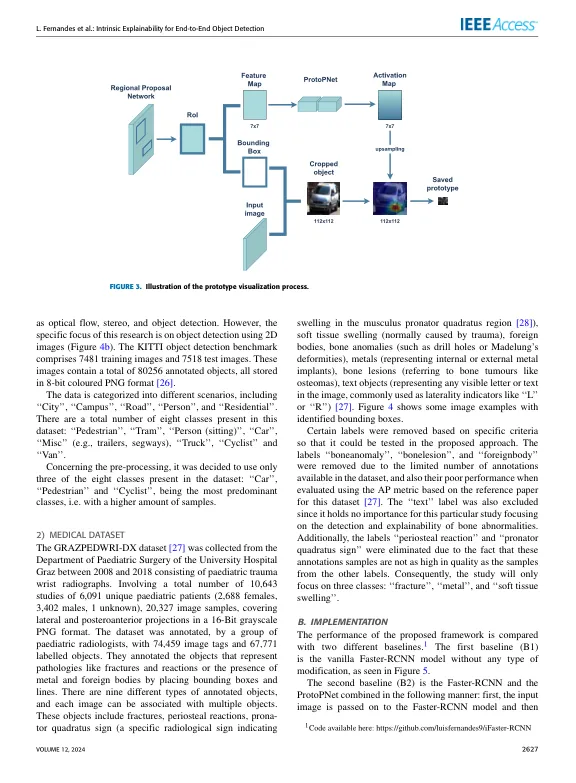

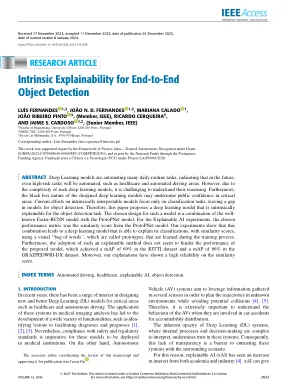

抽象的深度学习模型正在自动执行许多日常任务,表明将来,即使是高风险的任务也将是自动化的,例如医疗保健和自动化驱动区。但是,由于这种深度学习模型的复杂性,了解其推理是一项挑战。此外,设计的深度学习模型的黑匣子性质可能会破坏公众对关键领域的信心。当前对本质上可解释的模型的努力仅着眼于分类任务,而在对象检测中留下了差距。因此,本文提出了一个深度学习模型,该模型可用于对象检测任务。这种模型所选的设计是众所周知的快速RCNN模型与ProtopNet模型的组合。对于可解释的AI实验,所选的性能度量是Protopnet模型的相似性评分。我们的实验表明,这种组合导致了一个深度学习模型,该模型能够以相似性得分来解释其分类,并使用视觉上的“单词袋”(称为原型)在训练过程中学习。此外,采用这种可解释的方法似乎并没有阻碍提出的模型的性能,该模型在Kitti数据集中获得了69%的地图,而GrazpedWri-DX数据集则获得了66%的地图。此外,我们的解释对相似性得分的可靠性很高。

端到端对象检测的内在解释性