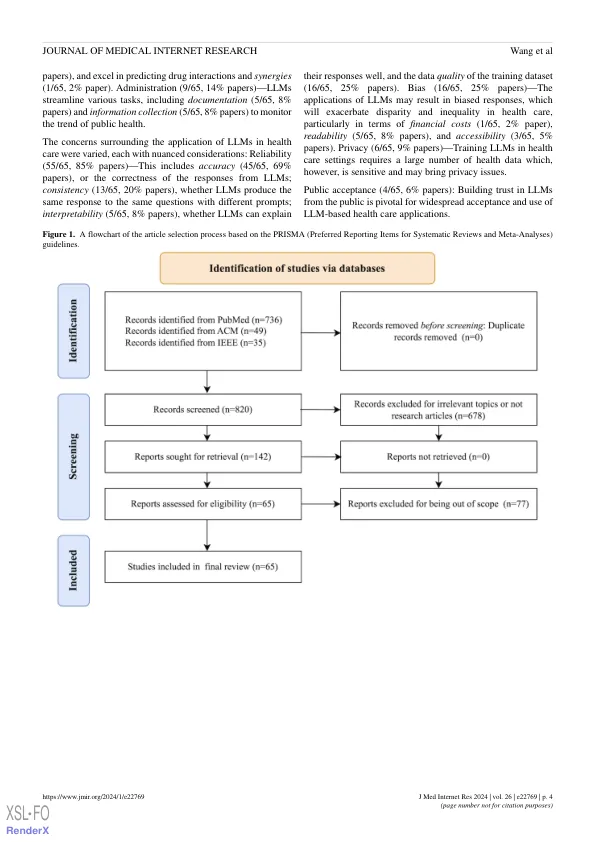

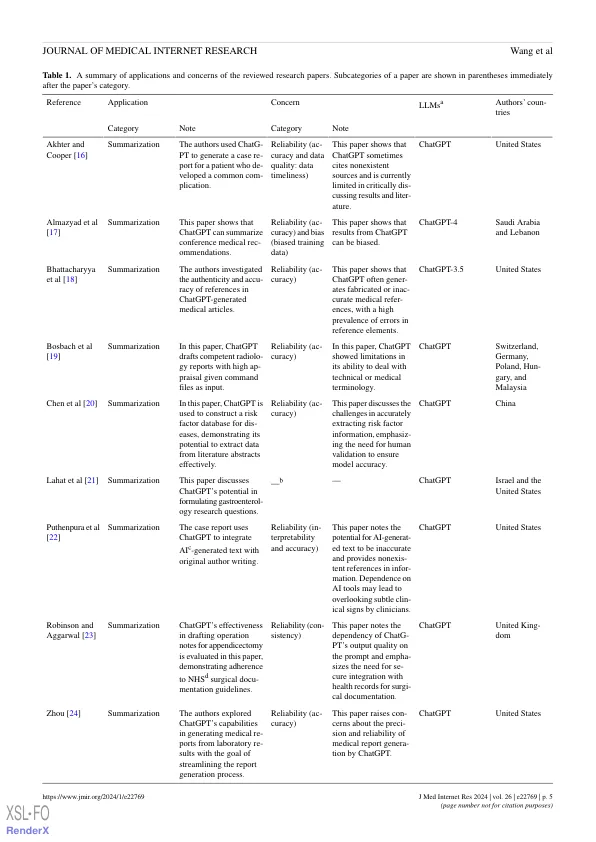

背景:2022年11月的Chatgpt(OpenAI)推出(OpenAI)引起了公众的关注和学术兴趣(LLMS),从而促进了许多其他创新的LLM的出现。这些LLM已应用于包括医疗保健在内的各个领域。从那以后,就如何在与健康相关的情况下使用最先进的LLM进行了许多研究。目的:本综述旨在总结有关卫生保健中对话性LLM的应用和疑虑,并为该领域的未来研究提供了议程。方法:我们使用PubMed,ACM和IEEE数字库作为本综述的主要来源。我们遵循Prisma(系统评价和荟萃分析的首选报告项目)的指导,并选择了经过同行评审的研究文章((1)与医疗保健应用和对话llms相关的研究文章,以及(2)在2023年9月1日之前发表,当时我们是我们启动纸质纸收藏的日期。我们调查了这些论文,并根据它们的应用和疑虑对它们进行了分类。结果:我们的搜索最初根据目标关键字确定了820篇论文,其中65(7.9%)的论文符合我们的标准,并将其包括在审查中。最受欢迎的对话llm是Chatgpt(60/65,92%的论文),其次是Bard(Google LLC; 1/65,1/65,2%的论文),Llama(Meta; 1/65; 1/65,2%的论文)和其他LLMS(6/65,9%,9%的论文)。使用LLMS进行了49篇论文,用于摘要或医学知识查询,或两者兼而有之,有58(89%)的论文表达了对可靠性或偏见或两者兼而有之的担忧。这些论文分为四类申请:(1)汇总,(2)医学知识查询,(3)预测(例如,诊断,治疗建议和药物协同作用),以及(4)管理(例如,文档和信息收集),以及四个类别的问题,以及四个类别:(1)可靠性(例如,培训数据质量,三),以及准确性,和一致性,和一致性,以及一致性,以及一致性,以及一致性,以及一致性,以及一致性,以及一致性,以及一致性,以及一致性,以及一致性,(3)隐私和(4)公众可接受性。我们发现,对话llms在摘要中表现出了令人鼓舞的结果,并为精度相对较高的患者提供一般医学知识。但是,诸如chatgpt之类的对话llms并不总是能够为需要专业领域专业知识的复杂健康相关任务(例如,诊断)提供可靠的答案。虽然偏见或隐私问题通常被视为关注点,但在我们的审查论文中没有实验研究对话性LLM在医疗保健研究中如何导致这些问题。

XSL•fo

主要关键词