机构名称:

¥ 1.0

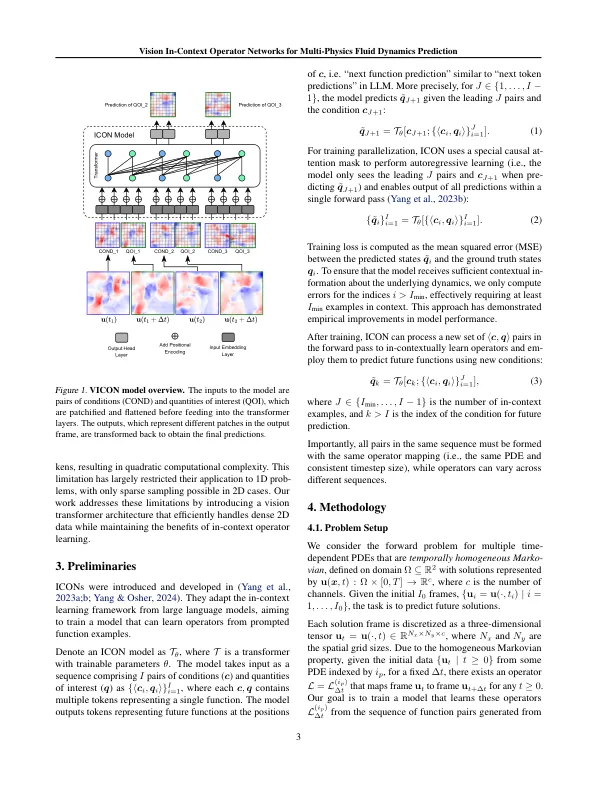

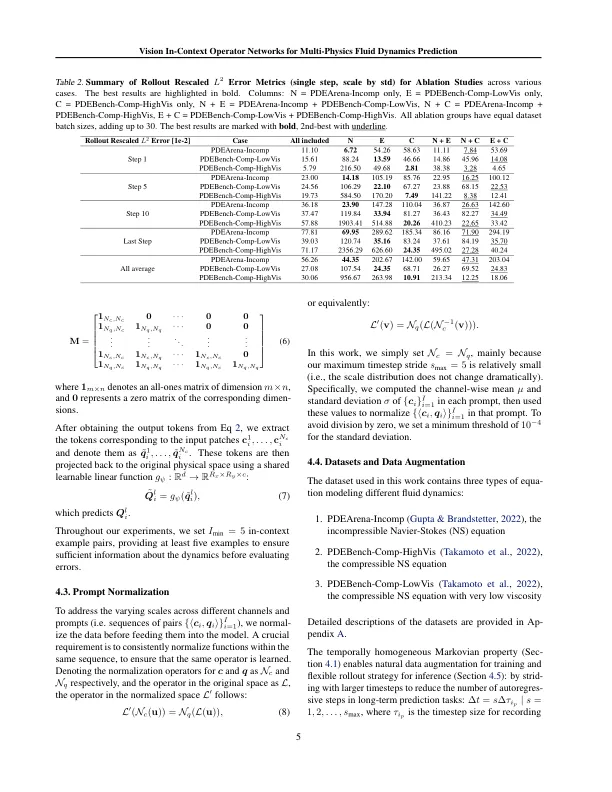

内部上下文运算符网络(图标)是使用几种射击的,内部的方法来学习不同类型PDE的操作员。al-尽管它们对各种PDE的成功概括,但现有方法将每个数据点视为一个令牌,并且在处理密集数据时会遭受构成效率低下的效率,从而限制了它们在较高空间尺寸中的应用。在这项工作中,我们提出了视觉中文本运算符网络(VICON),并结合了Vi-Sion Transformer架构,该体系结构有效地通过贴片操作来有效地填充2D函数。我们在三个流体动力学数据集上评估了我们的方法,这既证明了卓越的性能(将重新验证的L 2误差降低了40%和61。分别用于可压缩流的两个基准数据集和计算效率(仅需要每帧的推理时间的三分之一)在长期推出预测中与当前的最新序列到固定时间序列模型相比,具有固定时间段的序列模型:多个物理学预测(MPP)。与MPP相比,我们的方法保留了内部文化运算符学习的本元素,在处理不合格的框架计数或变化的时间段值时,可以实现柔性上下文形成。

VICON:愿景中文本运算符网络多...

主要关键词