机构名称:

¥ 1.0

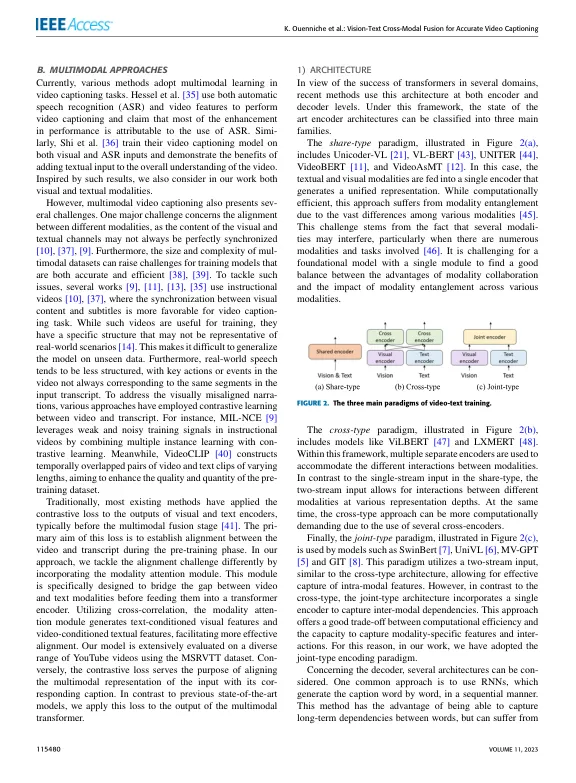

摘要在本文中,我们介绍了基于视觉和文本数据的跨模式融合的新型端到端多模式字幕字幕框架。所提出的方法集成了模态意见模块,该模块使用互相关捕获视觉文本间模型的关系。此外,我们将时间关注集成到3D CNN获得的功能中,以使用面向任务的培训来学习视频中的上下文信息。此外,我们结合了一项辅助任务,该任务采用对比损失函数来增强模型的概括能力并促进对模式间关系和潜在语义的更深入的理解。任务涉及将视频转录的多模式代表与标题表示形式进行比较,从而促进了模型中改善的性能和知识转移。最后,变压器架构用于使用注意机制有效捕获和编码文本和视频信息之间的相互依赖性。在解码阶段,变压器允许模型在编码功能中关注相关元素,有效地捕获了长距离依赖性,并最终生成具有语义意义的字幕。在MSRVTT基准测试上进行的实验评估验证了提出的方法,该方法的实验方法分别达到了BLEU4,Rouge和流星得分分别为0.4408、0.6291和0.3082。与最先进的方法相比,所提出的方法显示出卓越的性能,在所考虑的三个指标中,性能的增长范围从1.21%到1.52%。

视觉 - 文本交叉模式融合,用于准确的视频字幕

主要关键词