机构名称:

¥ 1.0

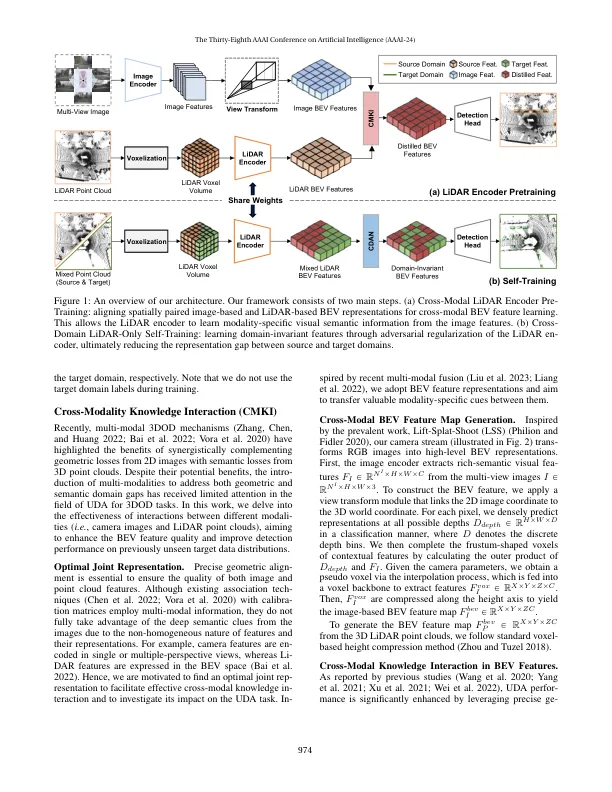

最近基于激光雷达的 3D 物体检测 (3DOD) 方法显示出良好的效果,但它们通常不能很好地推广到源(或训练)数据分布之外的目标域。为了减少这种领域差距,从而使 3DOD 模型更具泛化能力,我们引入了一种新颖的无监督领域自适应 (UDA) 方法,称为 CMDA,它 (i) 利用来自图像模态(即相机图像)的视觉语义线索作为有效的语义桥梁,以缩小跨模态鸟瞰图 (BEV) 表示中的领域差距。此外,(ii) 我们还引入了一种基于自训练的学习策略,其中模型经过对抗性训练以生成领域不变特征,这会破坏对特征实例是来自源域还是看不见的目标域的区分。总的来说,我们的 CMDA 框架指导 3DOD 模型为新颖的数据分布生成高度信息丰富且领域自适应的特征。在我们对 nuScenes、Waymo 和 KITTI 等大规模基准进行的大量实验中,上述内容为 UDA 任务提供了显著的性能提升,实现了最先进的性能。

CMDA:基于 LiDAR 的 3D 物体检测的跨模态和领域对抗自适应

主要关键词