机构名称:

¥ 1.0

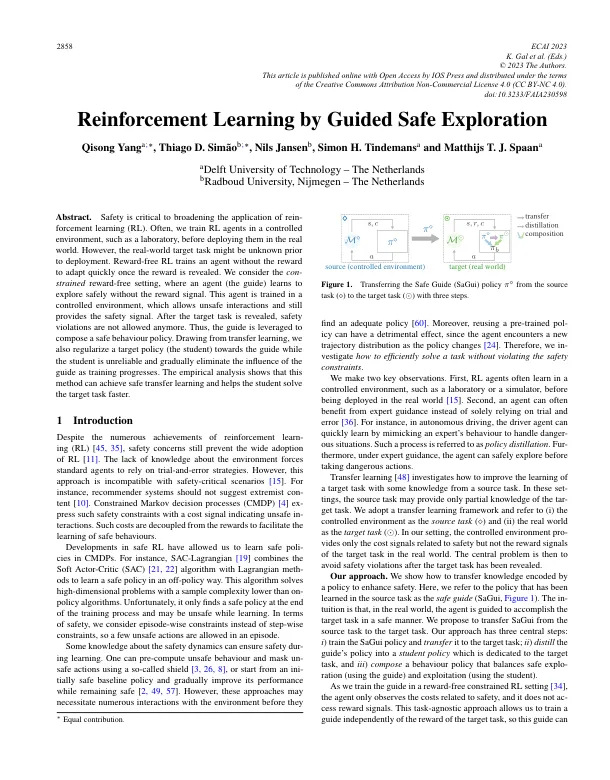

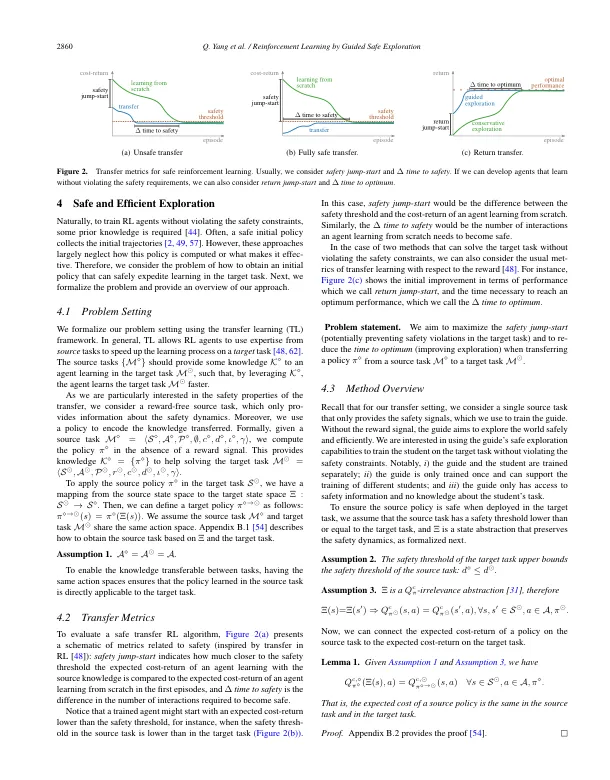

摘要。安全对于扩大重新执行学习(RL)的应用至关重要。通常,我们在将其部署在现实世界中之前,在受控环境(例如实验室)中训练RL代理。但是,现实世界的目标任务可能在部署前未知。无奖励RL训练代理,而无需奖励,一旦奖励揭示了奖励。我们考虑了无奖励的环境,代理(指南)学会了在没有奖励信号的情况下安全探索。该代理在受控环境中进行训练,该环境允许不安全的交互作用,并且仍然提供安全信号。揭示了目标任务后,不再允许违反安全性。因此,该指南被利用以制定安全的行为政策。从转移学习中绘制,我们还将目标政策(学生)正规化为指南,而学生不可靠,并且随着培训的进行,逐渐消除了指南的影响。经验分析表明,该方法可以实现安全的转移学习,并帮助学生更快地解决目标任务。

代尔夫特技术大学强化学习的学习...