机构名称:

¥ 1.0

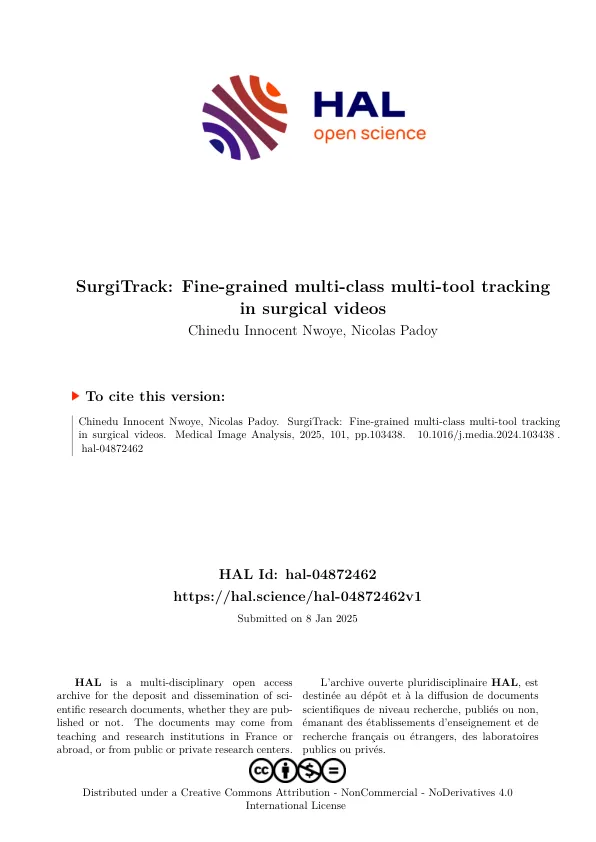

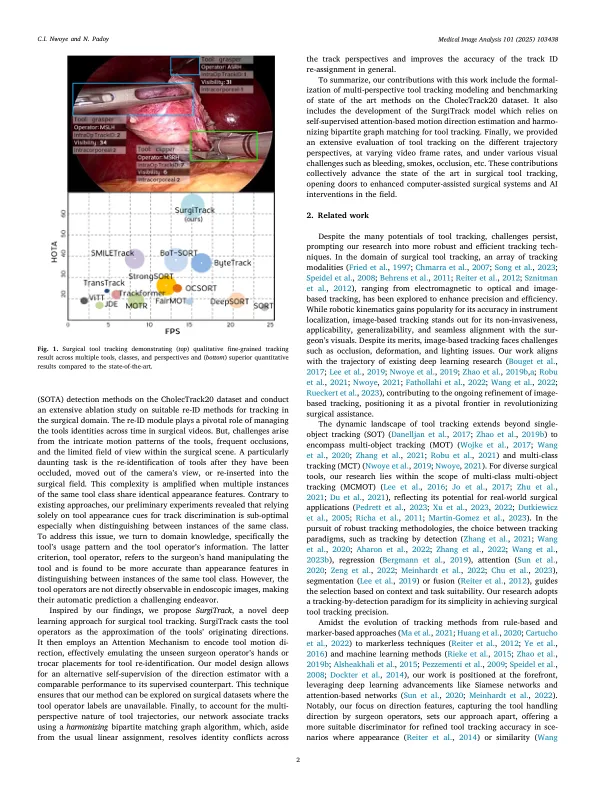

准确的工具跟踪对于计算机辅助干预的成功至关重要。以前的努力通常会严格地对工具轨迹进行建模,从而俯瞰外科手术程序的动态性质,尤其是跟踪诸如身体外和相机外视图之类的场景。在解决此限制时,新的CholectRack20数据集提供了详细的标签,以三个角度说明多个工具轨迹:(1)术中,(2)体内和(3)可见性,代表不同类型的工具轨迹时间。这些细粒标签可增强跟踪灵活性,但也提高了任务复杂性。由于高视觉相似性,尤其是在同一类别的工具中,遮挡或重新插入身体后的工具仍然具有挑战性。这项工作认识到工具操作员在区分工具轨道实例中的关键作用,尤其是属于同一工具类别的工具轨道实例。但是,在手术视频中未明确捕获操作员的信息。因此,我们提出了Surgitrack,这是一种利用Yolov7进行精确工具检测的新型深度学习方法,并采用了注意机制来对工具的起源方向进行建模,作为其操作员的代理,以重新识别工具。为了处理各种工具轨迹的观点,Surgitrack采用了协调的两分匹配图,最大程度地减少冲突并确保准确的工具身份关联。cholectrack20的实验结果证明了外科手术的有效性,优于实时推理能力的最先进方法和最先进的方法。这项工作为手术工具跟踪设定了新的标准,为在微创手术中提供了更适合适应性和精确的帮助。

手术视频中的精细粒度多级多级跟踪

主要关键词