机构名称:

¥ 1.0

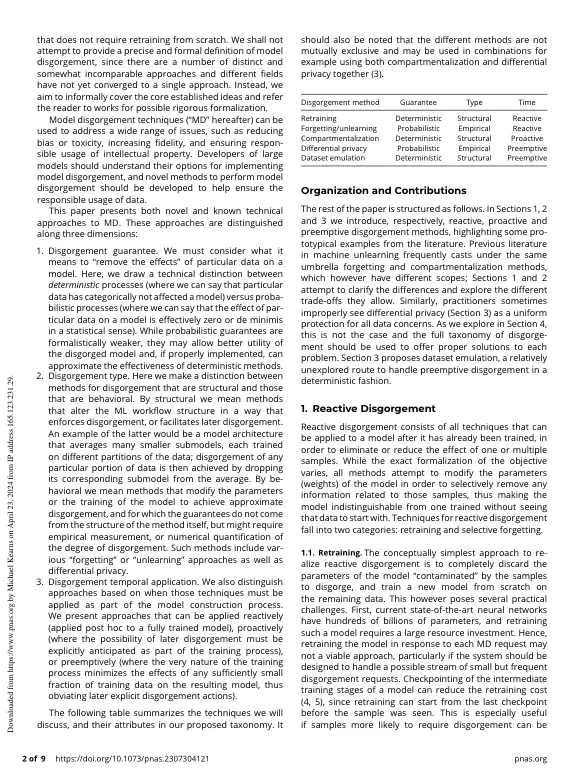

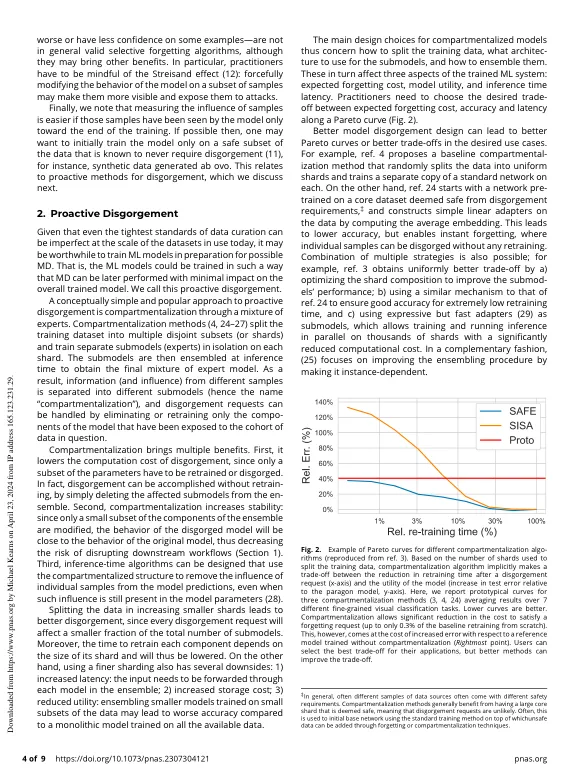

在过去的几年中,机器学习模型的大小和复杂性显着增加,尤其是在生成AI(例如大型语言模型)领域。这些模型需要大量的数据和计算能力进行培训,以至于无法通过删除或更改的可疑数据“从头开始”来研究“从头开始”的模型来实际解决培训数据(例如受保护或私人内容)的关注。此外,尽管有很大的效果和控件致力于确保培训语料库进行适当的策划和组成,但纯粹的音量会导致手动检查每个基于培训语料库的基准。一种潜在的训练语料库数据缺陷的方法是模型差异,我们通常意味着消除或减少不当使用的数据不当,而且还要减少对ML模型任何组件的不当数据的影响。模型差异技术可用于解决广泛的问题,例如降低偏见或毒性,增加忠诚度并确保负责使用知识产权。在本文中,我们调查了模型散布方法的陆地景观,并介绍了适用于现代ML系统的分类学分类法。特别是,我们以不需要从头开始的方式调查了受过训练的模型的“消除数据效应”的各种含义。

AI模型删除:方法和选择 - UPENN CIS

主要关键词