机构名称:

¥ 1.0

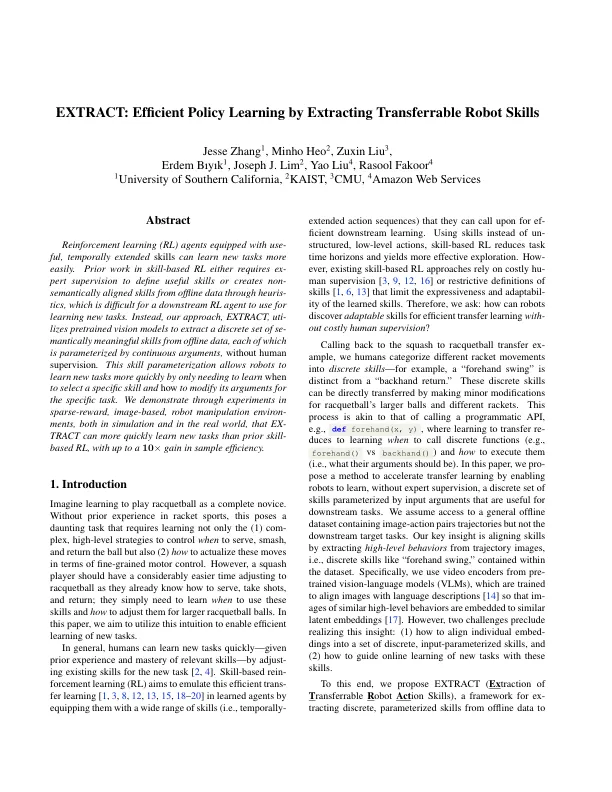

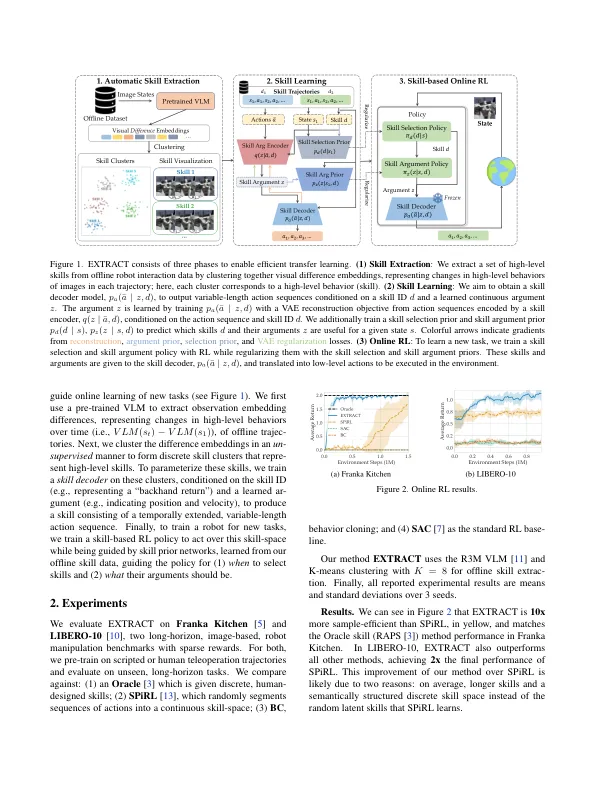

增强学习(RL)代理,配备有使用的时间扩展的技能可以更轻松地学习新任务。基于技能的RL的事先工作要么需要进行外部监督来定义有用的技能,要么通过启示录从离线数据中创建非语义上的技能,这对于下游RL代理来说很难用于学习新任务。取而代之的是,我们的方法,提取,介绍了验证的视觉模型,从离线数据中提取一套离散有意义的技能,每个技能都通过连续参数进行参数,而无需人为监督。此技能参数化使机器人只需要学习何时选择特定技能以及如何为特定任务修改其参数,从而更快地学习新任务。我们通过在模拟和现实世界中进行的稀疏奖励,基于图像的机器人操纵环境进行的实验来证明,这些措施比以前的基于技能的RL更快地学习了新任务,其样品效率最高为10倍。

提取:通过提取可转移机器人技能的有效政策学习