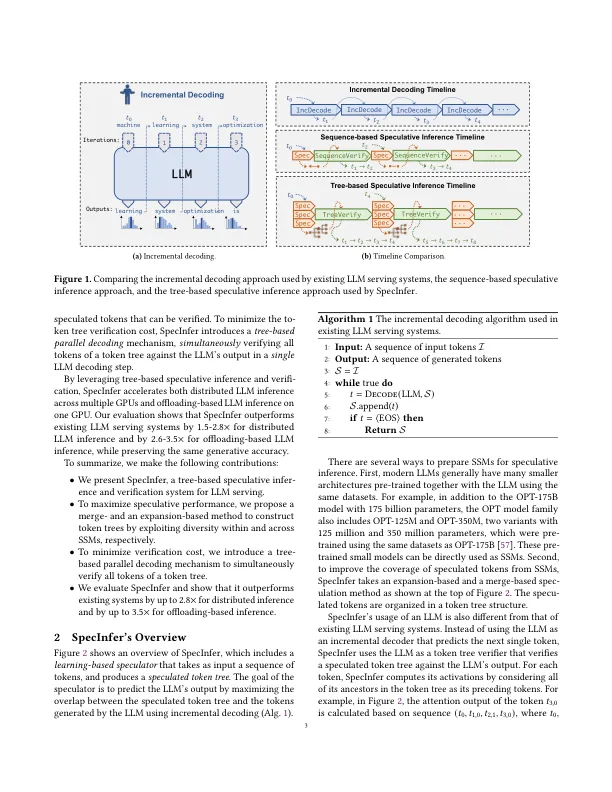

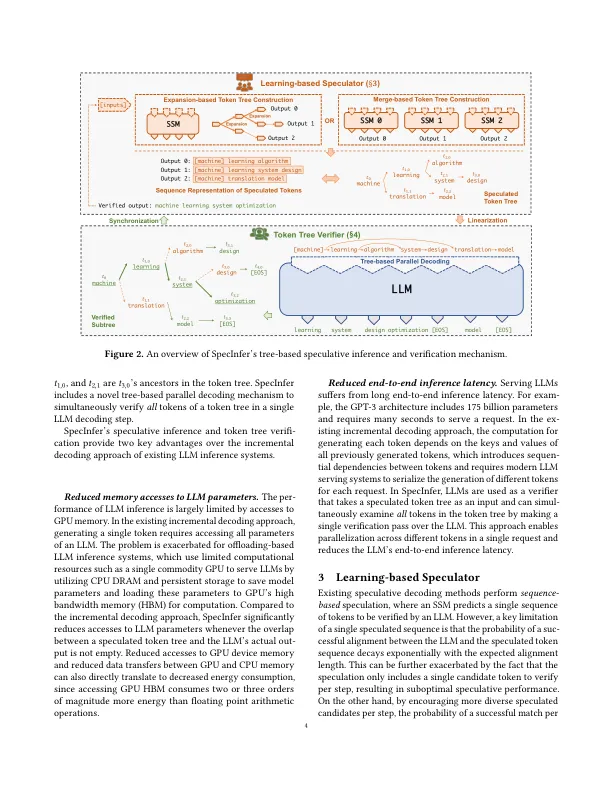

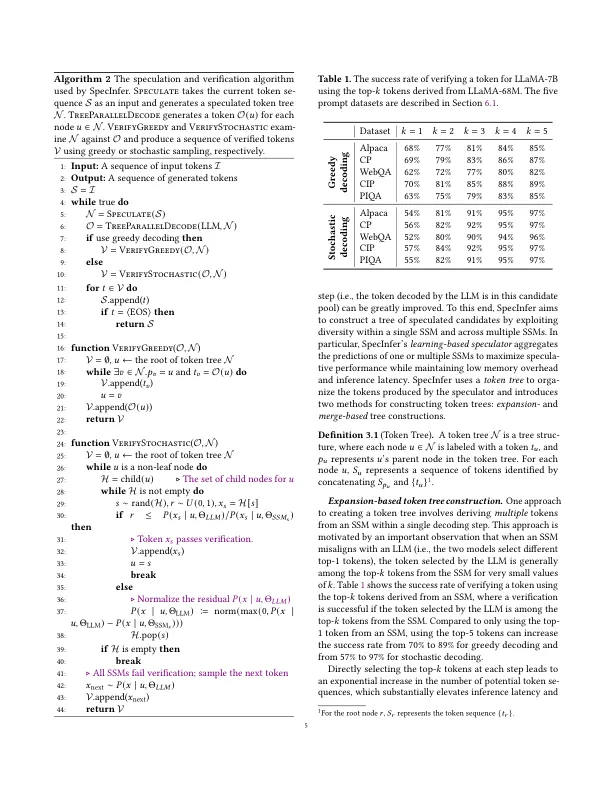

由于其大量参数,复杂的架构和较高的计算要求。例如,最大的GPT-3体系结构具有1750亿个参数,该参数需要八个以上的NVIDIA 40GB A100 GPU才能存储在半精确的浮点中,并且需要几秒钟才能提供单个推断请求[3]。llm通常作为输入一个令牌序列,称为提示,并一次生成后续令牌一个,如图1a所示。序列中每个令牌的生成都在输入提示和先前生成的令牌上进行条件,并且不考虑将来的令牌。此方法也称为自回归解码,因为每个生成的令牌也被用作生成未来令牌的输入。令牌之间的这种依赖性对于许多NLP任务至关重要,这些任务需要保留生成的令牌的顺序和上下文,例如文本完成[55]。现有的LLM系统通常使用增量解码方法来服务请求,其中系统在单个步骤中计算所有提示令牌的激活,然后使用输入提示和所有先前生成的令牌进行迭代解码一个新的令牌[27]。这种方法在代币之间依赖于数据依赖性,但是实现了亚最佳运行时性能和有限的GPU利用率,因为在每个请求中的并行程度在增量阶段中受到极大的限制。此外,变压器的注意机制[48]要求访问所有前任令牌的键和值,以计算新令牌的注意力输出。为了避免重新计算所有上述令牌的键和值,当今的LLM系统使用缓存机制存储其键和值以在将来的迭代中重新使用。对于长期生成任务(例如,GPT-4在请求中最多支持32K令牌),缓存键和值引入了重要的内存开销,这防止了现有系统由于存储器的键和值的要求而并行提供大量的记忆。是出于在进程优化中进行投机执行的概念[13,42],最近的工作引入了基于序列的投机推断,该推断利用了一个小的猜测模型(SSM)生成一个令牌序列,以生成一系列令牌并使用LLM在同时检查其正确性[5,22,22,22,22,22,22,22,22,444,44,44,51]。这些尝试仅考虑由单个SSM生成的令牌序列进行投机,因为它们之间的模型容量差距不能很好地与LLM保持一致,因为SSM通常比LLM小的数量级以保持低内存和运行时的空间开销。本文介绍了SpecInfer,该系统可以提高LLM的端到端潜伏期和计算效率,该系统具有基于树的投机推理和验证。图1b说明了现有的增量解码,基于序列的投机推断与基于树的投机推断之间的比较。一个关键的见解 - 指定者是同时考虑各种猜测候选者(而不是像现有的

指定:加速使用基于树的投机推理和验证的大型语言模型

主要关键词