机构名称:

¥ 2.0

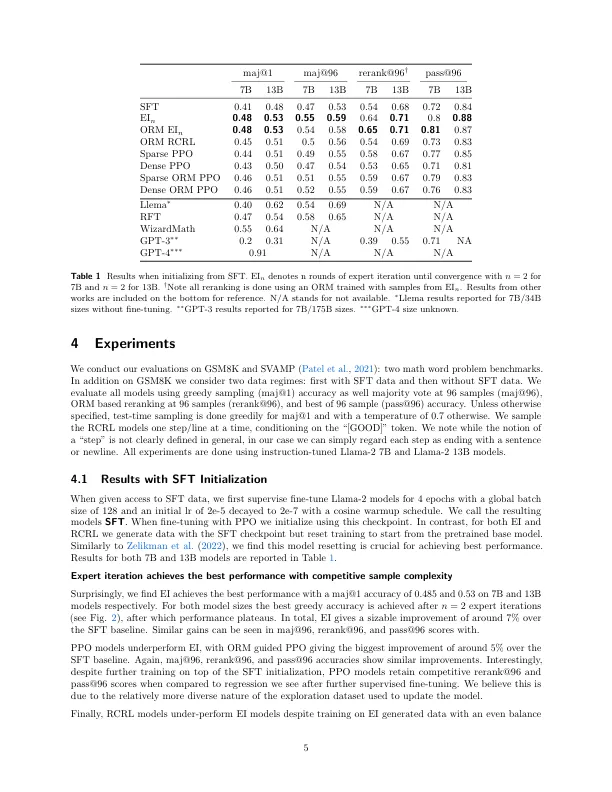

从人类反馈(RLHF)中学习的强化已成为将LLM输出与人类偏好相结合的主要方法。受RLHF成功的启发,我们研究了多种算法的性能,这些算法从反馈(专家迭代,近端策略优化(PPO),返回条件的RL)中学习,以提高LLM推理能力。我们通过学习的奖励模型调查了向LLM提供给LLM的稀疏和密集奖励。我们还从有或没有监督微调(SFT)数据的多个模型大小和初始化开始。总的来说,我们发现所有算法的性能都相当,在大多数情况下,专家迭代的表现最佳。令人惊讶的是,我们发现专家迭代的样本复杂性与PPO的样本复杂性相似,最多要求10 6个样本的顺序从预验证的检查点收敛。我们调查了为什么是这种情况,得出的结论是,在RL培训模型期间,无法探索超出SFT模型已经产生的解决方案。此外,我们在SFT培训期间讨论了Maj@1与96指标性能之间的权衡,以及RL训练如何同时改善这两种情况。然后,我们通过讨论我们的发现对RLHF的含义以及RL在LLM微调中的未来作用来得出结论。

教导大型语言模型通过加强学习进行推理

主要关键词