机构名称:

¥ 2.0

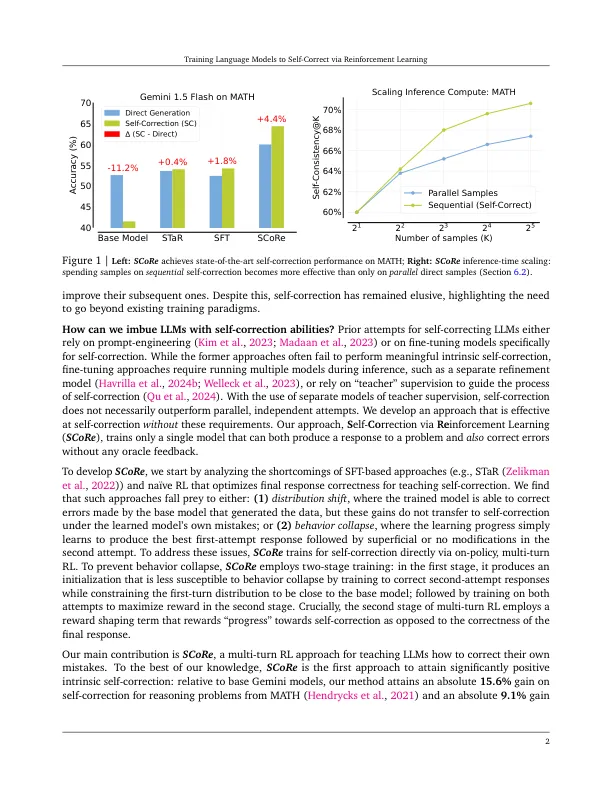

自我纠正是大语言模型(LLM)的高度理想能力,但一直发现它在现代LLM中基本上是无效的。当前的训练自我纠正方法通常取决于多个模型,更高级的模型或其他形式的监督。为了解决这些缺点,我们开发了一种多转弯的在线增强学习方法(RL)方法,该方法得分可显着提高LLM使用完全自我生成的数据的自我纠正能力。为了建立分数,我们首先表明,在离线模型生成的校正轨迹上,有监督的微调(SFT)的变体通常不足以灌输自我纠正行为。尤其是,我们观察到,通过SFT训练捕食猎物是数据收集策略和模型自身反应或行为崩溃之间的分布不匹配的猎物,在这些错误中,学习隐含地仅优先于某种某种校正模式,而这种校正方式通常在测试问题上自我纠正无效。分数通过在模型自身分配自我生成的校正轨迹的分布下进行训练,并使用适当的正则化来解决学习过程,以学习在测试时间有效的自我纠正行为,而不是适合给定提示的高回应。此正则化过程包括基本模型上多转移RL的初始阶段,以生成不易崩溃的策略初始化,然后使用奖励奖金来扩大自我纠正。使用Gemini 1.0 Pro和1.5 Flash模型,我们发现得分可以实现最新的自我纠正性能,将基本模型的自我纠正分别提高了15.6%和9.1%,并在数学和人道主义方面提高了9.1%。

通过强化学习培训语言模型

主要关键词