机构名称:

¥ 1.0

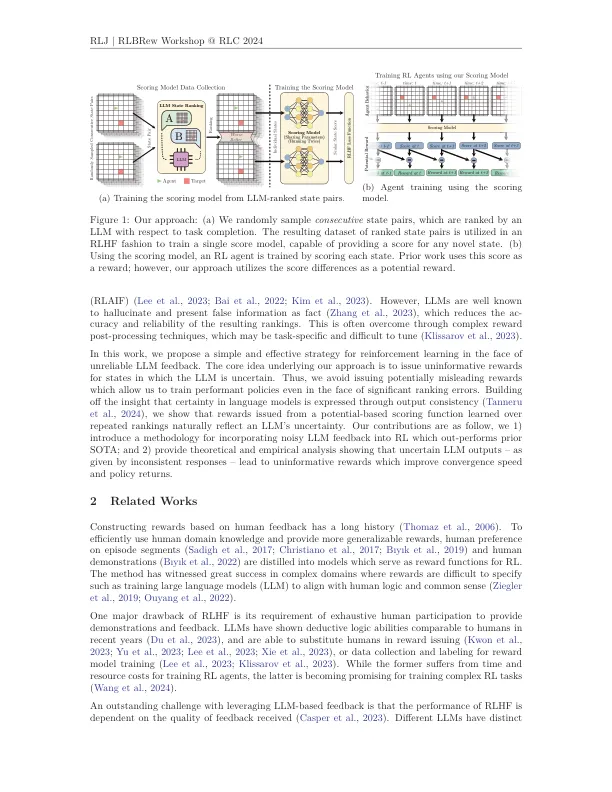

正确的奖励模型规范是增强学习的众所周知的挑战。手工制作的奖励功能通常会导致效率低下或次优政策,并且可能与用户值不符。从Human Feffack中学习的强化学习是一种成功的技术,可以减轻此类问题,但是,人类反馈的收集可能会很费力。最近的著作已从预先训练的大语言模型而不是人类中征求反馈,以减少或消除人类的努力,但是,在存在幻觉和其他错误的情况下,这些方法会产生较差的表现。在本文中,我们研究了从大语言模型反馈中进行强化学习的优点和限制,并提出了一种简单而有效的方法,用于征求和将反馈作为基于潜在的塑造功能。我们从理论上和经验上表明,与先前的工作相比,我们的方法会导致更高的政策回报,即使有重大的排名错误,并消除了对奖励功能进行复杂后处理的需求。

从大语言模型反馈中对强化学习的奖励分析