机构名称:

¥ 1.0

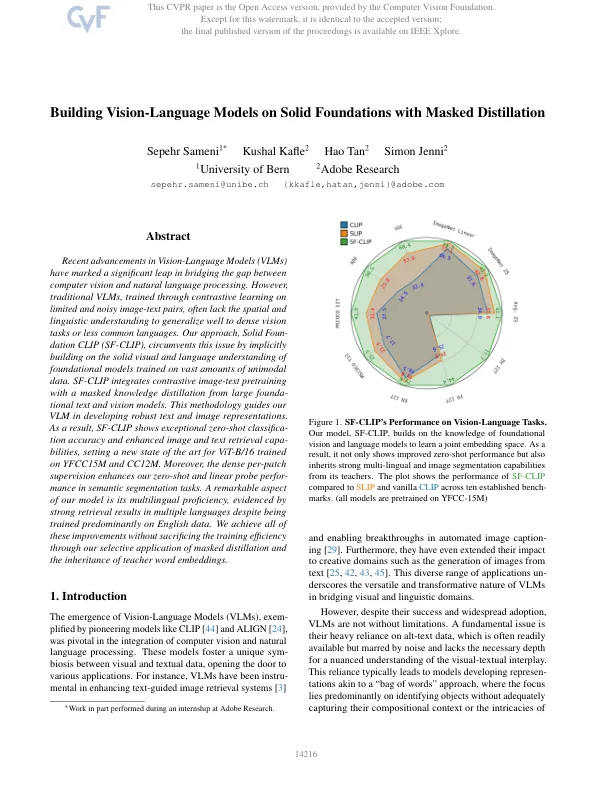

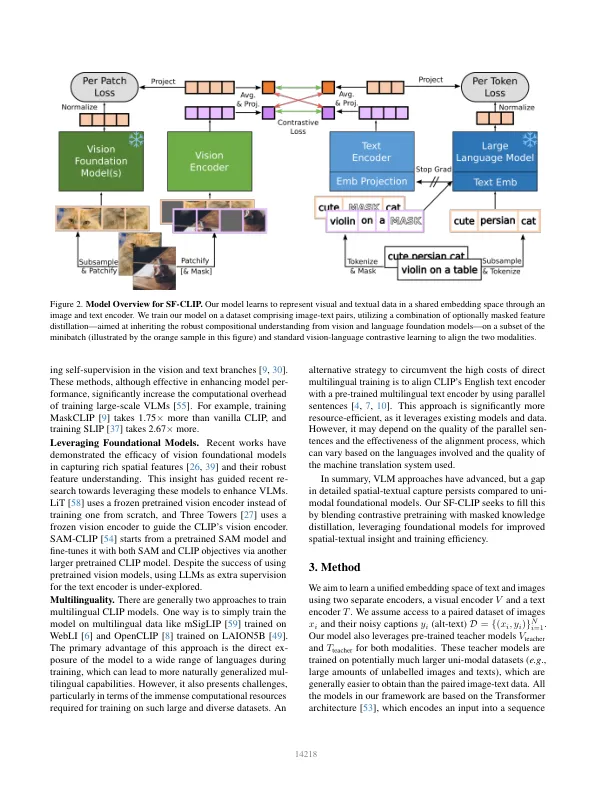

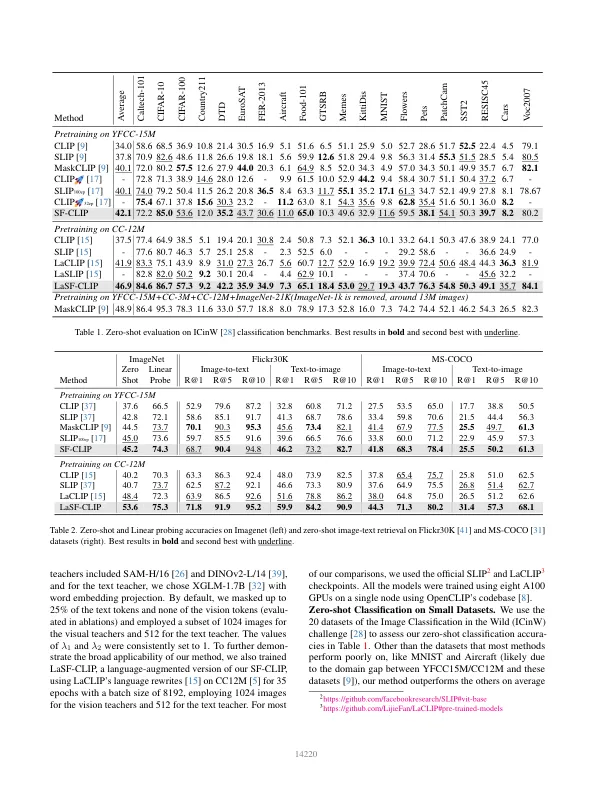

视觉模型(VLM)的最新进步在弥合计算机视觉和自然语言处理之间的差距方面取得了重大飞跃。然而,传统的VLM通过对有限和嘈杂的图像文本对进行对比学习训练,通常缺乏空间和语言的理解,可以很好地推广到密集的视觉任务或更少的通用语言。我们的方法,坚实的基础剪辑(SF-CLIP),通过隐式建立对经过大量单峰数据训练的基础模型的可靠的视觉和语言理解来避免此问题。sf-clip将对比的图像文本预测与大型基础文本和视觉模型的掩盖知识蒸馏。这种方法可以指导我们的VLM开发强大的文本和图像表示。结果,SF-CLIP显示出异常的零射击分类精度,并增强了图像和文本检索能力,为在YFCC15M和CC12M上训练的VIT-B/16的新最新状态。此外,在语义分割任务中,密集的每个斑点监督增强了我们的零射击和线性探针的性能。我们模型的一个了不起的方面是它的多语言能力,尽管主要接受了英语数据的培训,但通过多种语言的强劲检索结果证明了这一点。我们通过选择性地应用掩盖的蒸馏和教师单词嵌入的继承来实现所有这些改进,而无需牺牲培训效率。

在固体基础上建立视觉模型的模型

主要关键词