机构名称:

¥ 1.0

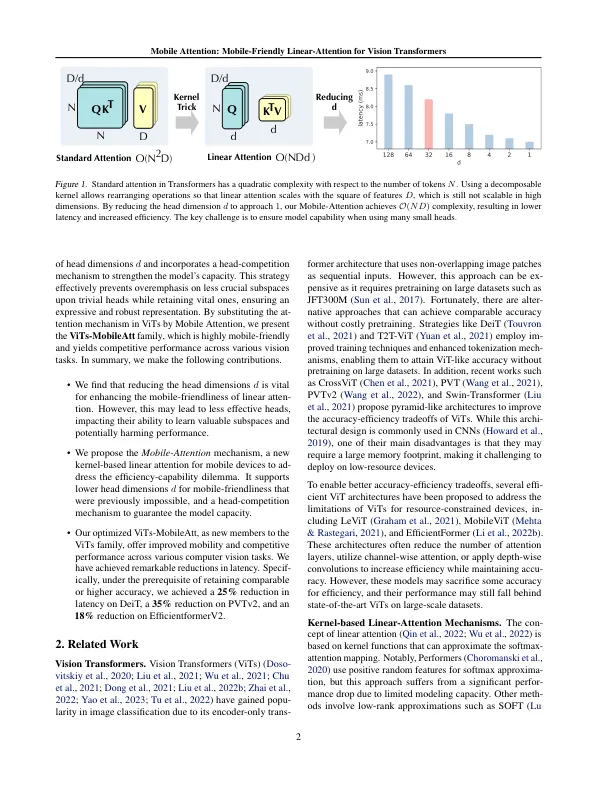

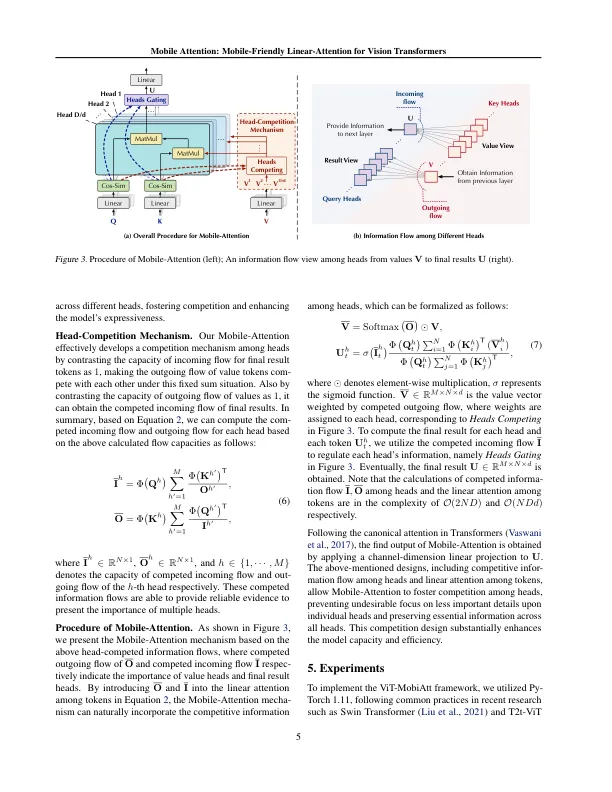

Vision Transformers(Vits)在计算机VI-SION任务中出色,因为它们能够捕获令牌之间的全局上下文。但是,它们的二次复杂性o(n 2 d)就令牌数字n和功能尺寸d限制了移动设备上的实际使用,因此需要更加移动友好的VIT,并减少延迟。多头线性注意事项正在成为有前途的替代品,具有线性复杂性o(ndd),其中d是每个头尺寸。仍然需要更多的计算,因为d变得较大,以达到模型的准确性。降低D可以提高移动友好性,而牺牲了过度小头弱,但在学习有价值的子空间方面,最终阻碍了模型能力。为了克服这一效率难题,我们提出了一种新型的移动意见设计,并具有通过信息流赋予的头部竞争机制,这防止了过分强调琐碎的头部上的不太重要的子空间,同时保留了必要的子空间,以确保变压器的能力。它通过支持一个小尺寸d的小型动作效率来实现移动设备上的线性时间复杂性。通过移动注意事项替换VIT的标准注意力,我们优化的VIT在一系列计算机视觉任务中实现了增强的模型容量和竞争性的表现。特定的,我们已经在iPhone 12上实现了延迟的显着降低。代码可从https://github.com/thuml/mobileattention获得。

视觉变压器的移动友好线性注意力

主要关键词