机构名称:

¥ 1.0

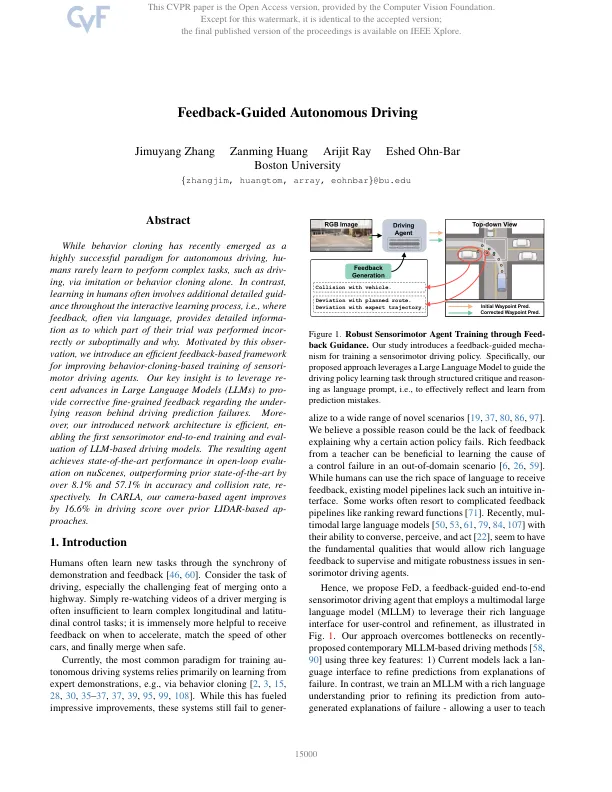

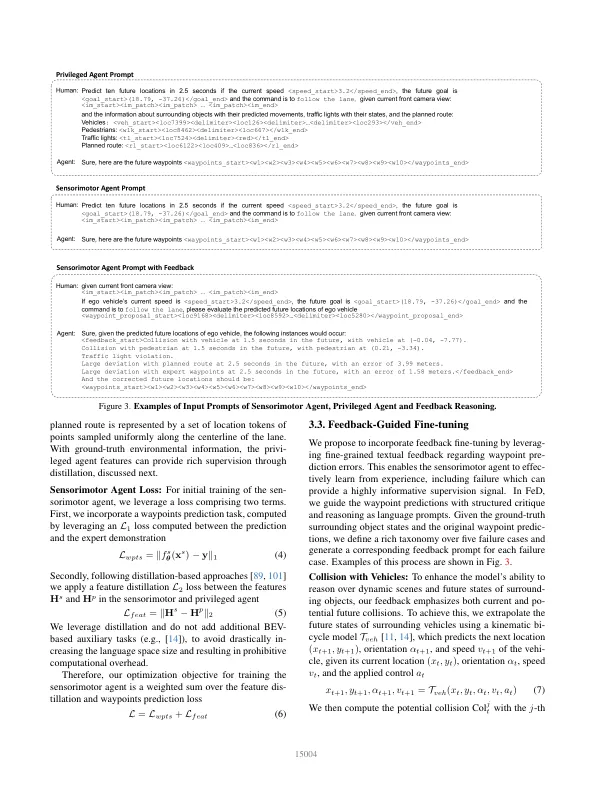

虽然行为克隆最近已成为自主驾驶的非常成功的范式,但Humans很少学会通过单独的模仿或行为克隆来执行复杂的任务,例如驱动或行为。相比之下,人类的学习通常涉及在整个交互式学习过程中的其他详细指导,即通常通过语言的反馈提供详细的信息,以详细信息,以进行审判的哪一部分进行,不正确或次要地进行。以这种观察的启发,我们引入了一个有效的基于反馈的框架,用于改善基于行为克隆的传感驱动剂培训。我们的关键见解是利用大语模型(LLM)的重新进步,以提供有关驾驶预测失败背后的理由的纠正良好的反馈。更重要的是,我们引入的网络体系结构是有效的,是第一个基于LLM的驾驶模型的第一个感觉运动端到端培训和评估。最终的代理在Nuscenes上的开环评估中实现了最新的性能,在准确性和碰撞率上的表现优于先前的最新时间超过8.1%和57.1%。在卡拉(Carla)中,我们的基于相机的代理在以前的基于激光雷达的AP摄入率上提高了16.6%的驾驶得分。

反馈引导的自主驾驶-CVF Open Access

主要关键词