机构名称:

¥ 1.0

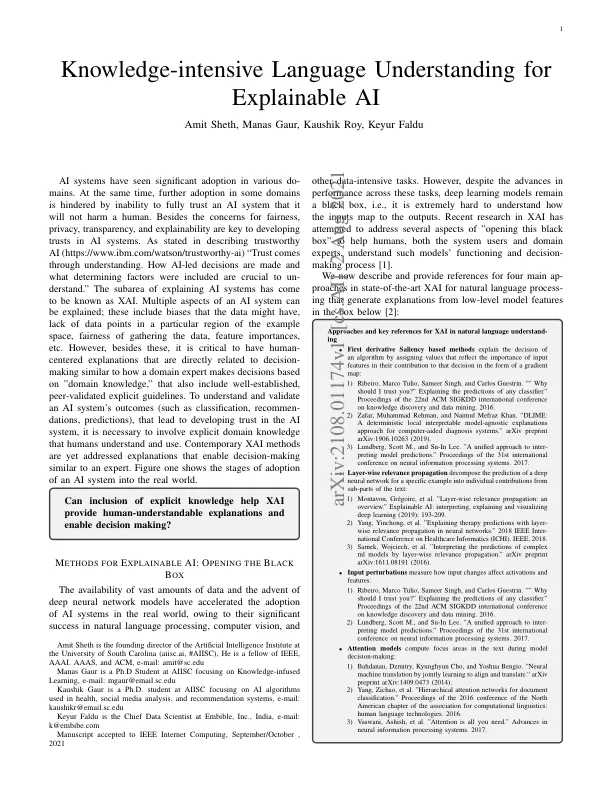

人工智能系统已在各个领域得到广泛应用。与此同时,由于无法完全信任人工智能系统不会伤害人类,因此某些领域的进一步应用受到阻碍。除了公平性之外,隐私、透明度和可解释性也是建立对人工智能系统的信任的关键。正如在描述值得信赖的人工智能 (https://www.ibm.com/watson/trustworthy-ai) 中所述,“信任源于理解。理解人工智能主导的决策是如何做出的以及其中包括哪些决定性因素至关重要。”解释人工智能系统的子领域被称为 XAI。可以解释人工智能系统的多个方面;这些包括数据可能存在的偏差、示例空间特定区域缺少数据点、收集数据的公平性、特征重要性等。然而,除此之外,至关重要的是要有以人为本的解释,这些解释与决策直接相关,类似于领域专家如何根据“领域知识”做出决策,其中还包括完善的、同行验证的明确指南。为了理解和验证 AI 系统的结果(如分类、推荐、预测),从而建立对 AI 系统的信任,有必要涉及人类理解和使用的明确领域知识。当代的 XAI 方法尚未解决能够像专家一样做出决策的解释。图 1 展示了 AI 系统在现实世界中的应用阶段。

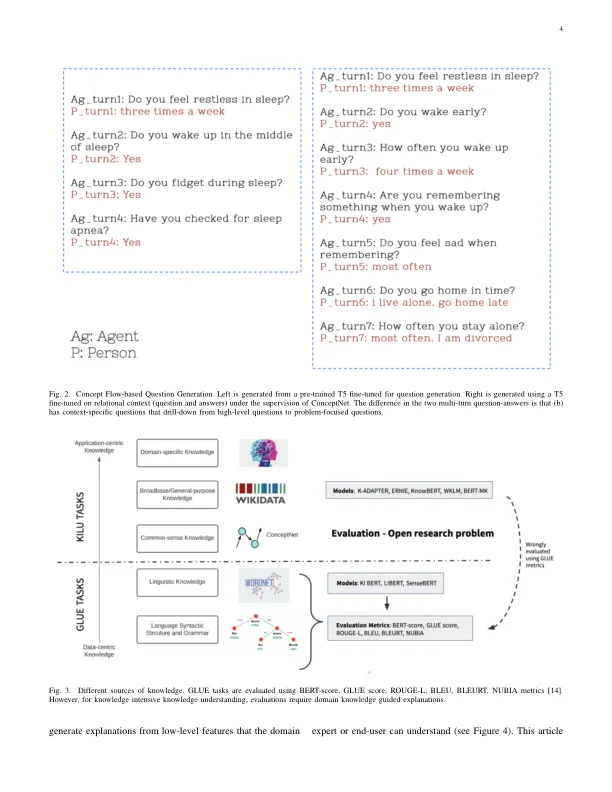

可解释人工智能的知识密集型语言理解

主要关键词