机构名称:

¥ 1.0

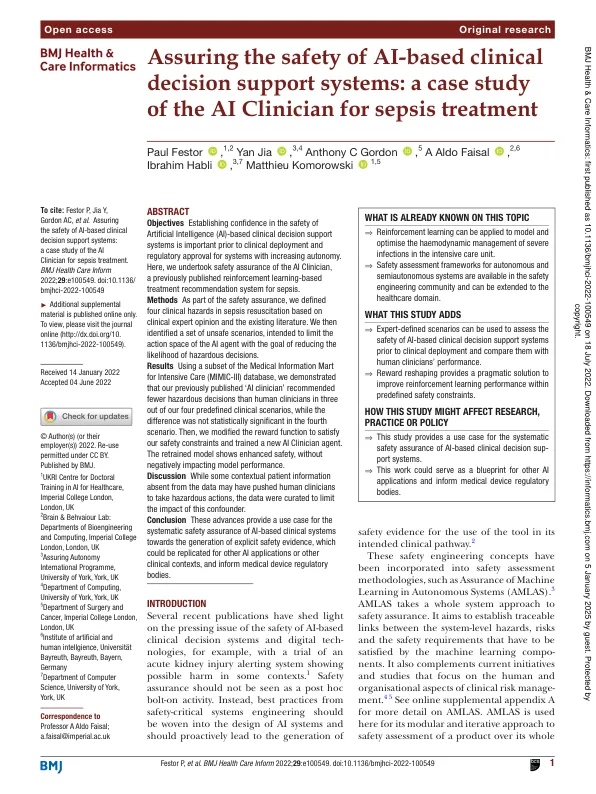

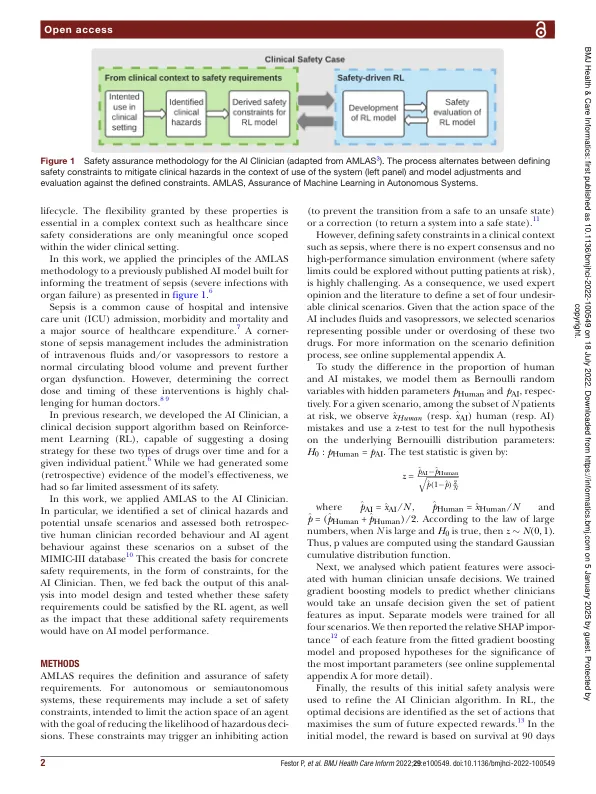

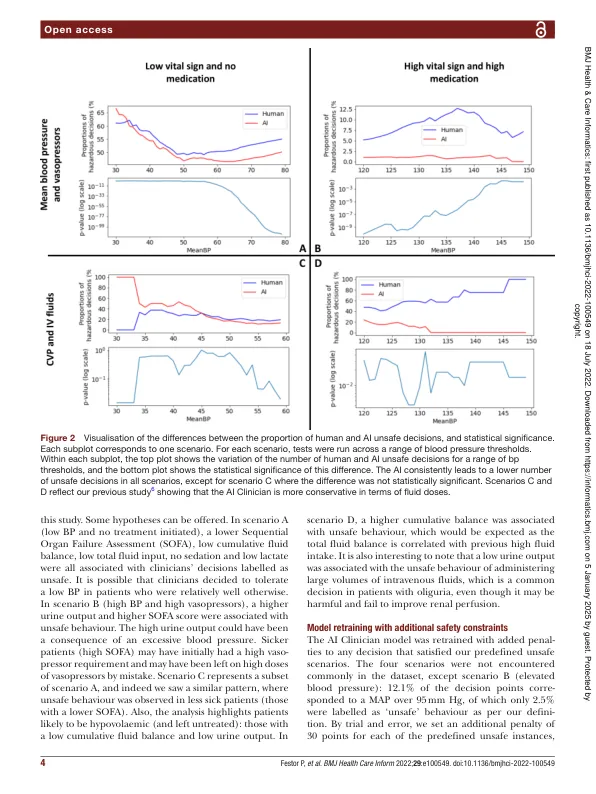

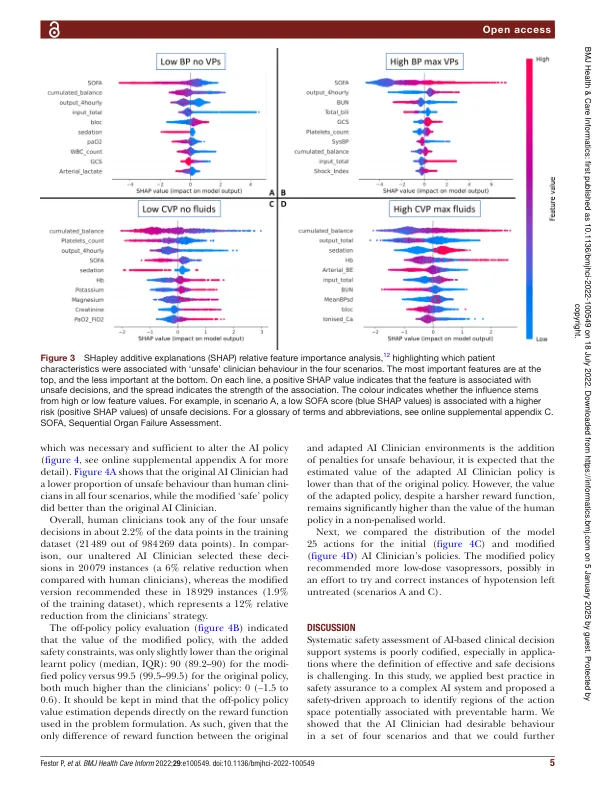

摘要 目的 在基于人工智能 (AI) 的临床决策支持系统进行临床部署和获得监管部门批准之前,建立对该系统安全性的信心对于提高自主性至关重要。在此,我们对 AI Clinician 进行了安全保障,AI Clinician 是一个之前发布的基于强化学习的脓毒症治疗推荐系统。 方法 作为安全保障的一部分,我们根据临床专家意见和现有文献定义了脓毒症复苏中的四种临床危害。然后,我们确定了一组不安全的场景,旨在限制 AI 代理的行动空间,以降低做出危险决策的可能性。 结果 使用重症监护医学信息集市 (MIMIC-III) 数据库的一个子集,我们证明,在我们预定义的四种临床场景中的三种中,我们之前发布的“AI 临床医生”推荐的危险决策比人类临床医生少,而在第四种场景中差异并不具有统计学意义。然后,我们修改了奖励函数以满足我们的安全约束并训练了一个新的 AI Clinician 代理。重新训练的模型显示出增强的安全性,而不会对模型性能产生负面影响。讨论虽然数据中缺少一些背景患者信息可能会促使人类临床医生采取危险行动,但数据经过精心策划,以限制这种混杂因素的影响。结论这些进展为基于人工智能的临床系统的系统安全保障提供了一个用例,可以生成明确的安全证据,这些证据可以复制到其他人工智能应用或其他临床环境中,并为医疗器械监管机构提供信息。

败血症治疗人工智能临床医生案例研究

主要关键词