机构名称:

¥ 2.0

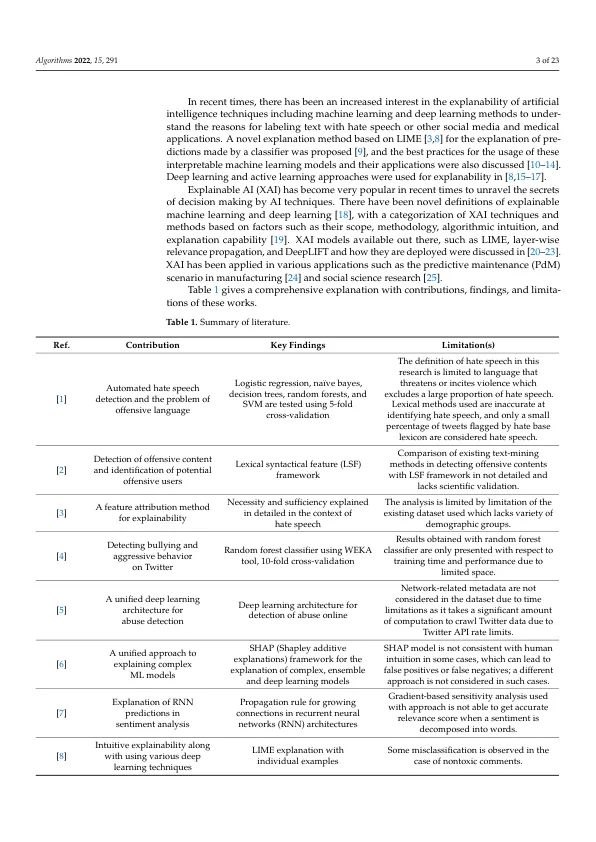

摘要:可解释人工智能 (XAI) 特性在深度学习模型的仇恨言论检测中具有灵活和多方面的潜力。本研究的目的是解释和说明复杂人工智能 (AI) 模型做出的决策,以了解这些模型的决策过程。作为本研究的一部分,我们采用了两个数据集来演示使用 XAI 进行仇恨言论检测。我们进行了数据预处理,以清除数据中的任何不一致之处、清理推文文本、对文本进行标记和词形还原等。我们还简化了分类变量,以便生成干净的数据集用于训练目的。我们对数据集进行了探索性数据分析,以发现各种模式和见解。我们将各种预先存在的模型应用于 Google Jigsaw 数据集,例如决策树、k-最近邻、多项朴素贝叶斯、随机森林、逻辑回归和长短期记忆 (LSTM),其中 LSTM 的准确率达到 97.6%。将 LIME(局部可解释模型 - 不可知解释)等可解释方法应用于 HateXplain 数据集。创建了 BERT(来自 Transformer 的双向编码器表示)模型的变体,例如准确率为 93.55% 的 BERT + ANN(人工神经网络)和准确率为 93.67% 的 BERT + MLP(多层感知器),以在使用 ERASER(评估基本原理和简单英语推理)基准的可解释性方面取得良好的表现。

文章 使用可解释人工智能 (XAI) 检测社交媒体仇恨言论

主要关键词