机构名称:

¥ 1.0

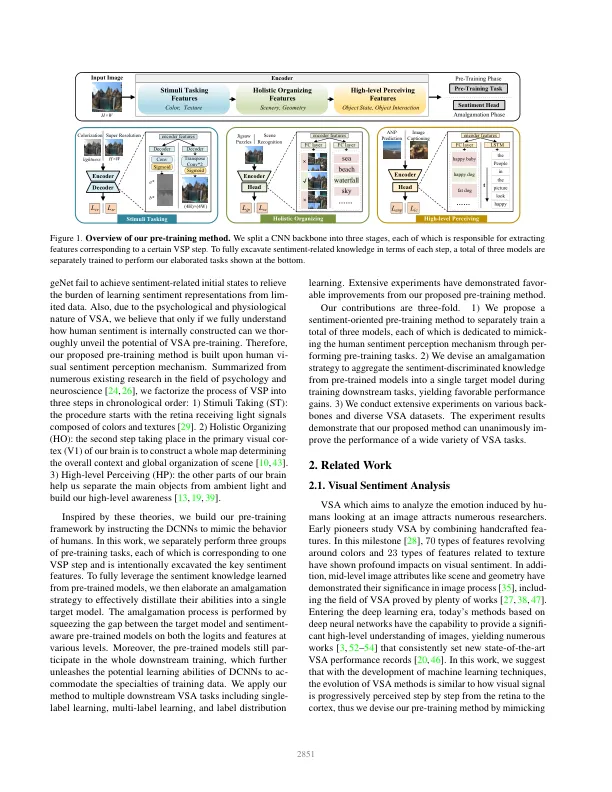

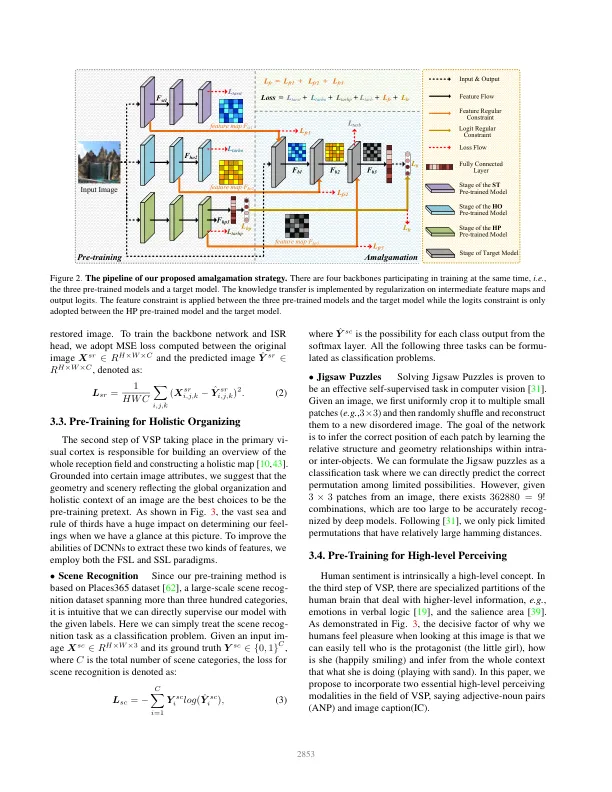

深度卷积神经网络(DCNN)的预训练在视觉情绪分析(VSA)领域起着至关重要的作用。大多数提出的方法都采用在大型物体分类数据集(即 ImageNet)上预训练的现成的主干网络。虽然与随机初始化模型状态相比,它在很大程度上提高了性能,但我们认为,仅在 ImageNet 上进行预训练的 DCNN 可能过于注重识别物体,而未能提供情绪方面的高级概念。为了解决这个长期被忽视的问题,我们提出了一种基于人类视觉情绪感知(VSP)机制的面向情绪的预训练方法。具体而言,我们将 VSP 的过程分为三个步骤,即刺激接受、整体组织和高级感知。通过模仿每个 VSP 步骤,我们通过设计的情绪感知任务分别对三个模型进行预训练,以挖掘情绪区分的表示。此外,结合我们精心设计的多模型融合策略,从每个感知步骤中学习到的先验知识可以有效地转移到单个目标模型中,从而获得显着的性能提升。最后,我们通过大量实验验证了我们提出的方法的优越性,涵盖了从单标签学习(SLL)、多标签学习(MLL)到标签分布学习(LDL)的主流 VSA 任务。实验结果表明,我们提出的方法在这些下游任务中取得了一致的改进。我们的代码发布在 https://github.com/tinglyfeng/sentiment_pretraining 。

受人类情感感知机制启发的情感导向预训练探索

主要关键词

![需求感知人工智能:为[人类]服务的人工智能……](/simg/8/87644e3a5af56d81bb96ffefb4a38030d8fa5f1c.png)