机构名称:

¥ 1.0

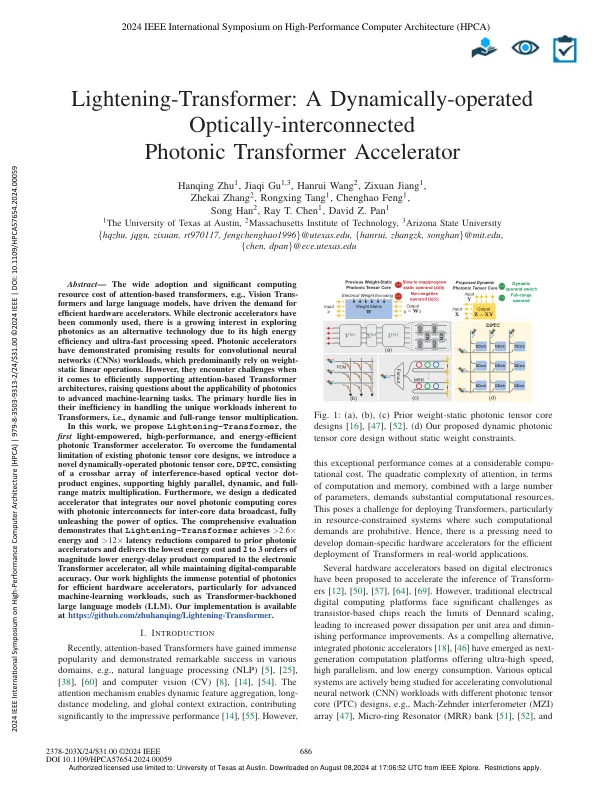

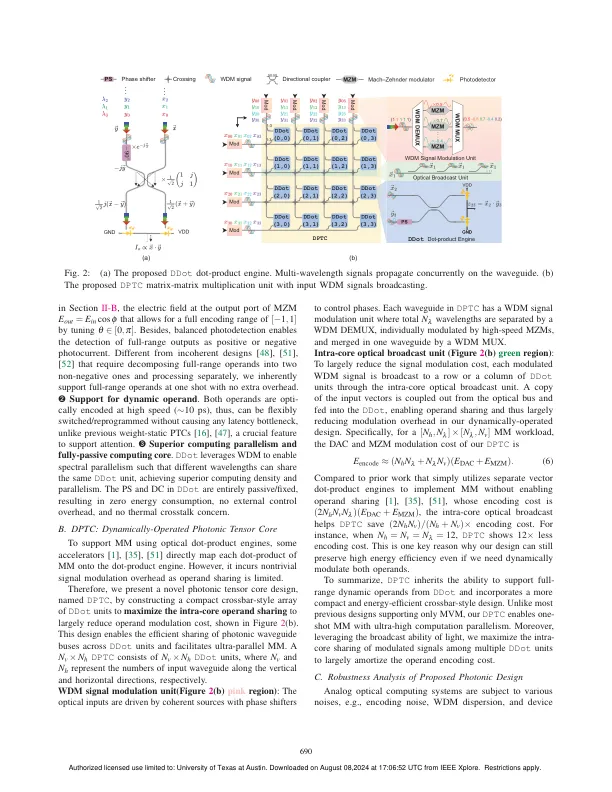

摘要 - 基于注意力的变压器的广泛采用和显着的计算资源成本,例如,视觉传输者和大型语言模型,驱动了对有效的硬件加速器的需求。尽管通常使用了电子加速器,但由于其高能量效率和超快速处理速度,人们对将光子学作为替代技术越来越兴趣。光子加速器已经证明了卷积神经网络(CNN)工作负载的有希望的结果,这些工作主要依赖重量 - 静态线性操作。但是,在有效地支持基于注意力的变压器体系结构方面,它们会遇到挑战,从而提出了有关光子学对高级机器学习任务的适用性的问题。主要障碍在于其不具体率在处理变压器固有的独特工作负载,即动态和全范围张量乘法。在这项工作中,我们提出了闪电转换器,第一个光功率,高性能和能量良好的光子变压器加速器。为了克服现有的光子张量核心设计的基本限制,我们引入了一种新型的动态动态光子张量核心DPTC,由基于干扰的光学矢量点发动机组成,支持高度平行,动态和全范围二元组乘积。此外,我们设计了一个专用的加速器,该加速器将我们的新型光子计算核与光子互连集成在一起,用于核心数据间广播,完全释放了光学功能。全面的评估表明,闪电转变器成就> 2。6×能量和> 12×延迟降低,并且与电子变压器加速器相比,能量成本最低,能量延迟产品低2至3个数量级,同时维持数字可靠的精度。我们的工作强调了光子学对于有效的硬件加速器的巨大潜力,尤其是用于高级机器学习工作负载,例如诸如变形金刚的大型语言模型(LLM)。我们的实施可在https://github.com/zhuhanqing/lightening-transformer上获得。

闪电转换器:动态操作的光学上 -

主要关键词