1美国国立卫生研究院(NIH),美国国立卫生研究院(NIH),美国马里兰州贝塞斯达2已经提出了大型语言模型(LLMS)来支持许多医疗保健任务,包括疾病诊断和治疗个性化。虽然可以应用AI来协助或增强医疗保健的提供,但也存在滥用的风险。llms可用于通过不公平,不公正或不准确的标准分配资源。例如,社会信贷系统使用大数据来评估社会中的“可信赖性”,对那些基于仅由权力结构定义的评估指标(例如,公司实体或管理机构)定义的评分量很差的人进行了惩罚。强大的LLM可以扩大此类系统,该系统可以根据多模式数据 - 金融交易,Internet活动和其他行为输入来评估个人。医疗保健数据可能是最敏感的信息,可以通过“临床信贷系统”收集,并有可能用于侵犯公民自由或其他权利,这可能包括限制获得护理的访问。这项研究的结果表明,LLM可能会偏向于保护个人权利的集体或系统利益,从而有可能使这种未来的滥用。此外,本报告中的实验模拟了如何使用当前LLM利用临床数据集,以证明解决这些道德危险的紧迫性。1。最后,提出了策略来减轻开发大型AI医疗模型的风险。简介大语模型(LLMS)可以使用非结构化数据执行许多复杂的任务 - 在某些情况下,除了人类功能之外。1,2这种进步正在扩展到医疗保健:正在开发新的AI模型来使用患者数据进行任务,包括诊断,工作流程改进,监测和个性化治疗建议。但是,如果被管理当局,公司或其他决策实体滥用,临床AI潜在应用的这种增加也会给公民自由带来重大风险。对这种潜力的认识可能会降低风险,激励透明度,为负责任的治理政策提供信息,并导致开发针对“大数据压迫”的新保障措施。1.1社会信用系统社会信贷系统已在中国人民共和国(中国)引入,是大数据压迫的新兴例子。社会信贷系统旨在限制“被抹黑”的特权,但不能限制“可信赖”的特权。 3-23在社会信贷系统中,从公民/成员收集的大型多模式数据集可用于确定社会内的“可信赖性”,该指标是基于由权力结构定义和控制的指标。3-23被认为是值得信赖的,公民必须表现出对权力结构的忠诚,并与已建立的专业,财务和社会(行为)标准保持一致。否则,他们可能会失去自己和亲人的关键资源的访问权限。24例如,对管理机构的批评可能会导致旅行,就业,医疗服务和/或教育机会的限制。3-23甚至非常小的“犯罪”,例如轻率的购买,停车票或过度的在线游戏,也可能导致处罚。21-23最终,从电力结构中获取资源,威胁力量结构或以其他方式被认为是不受欢迎/不信任的任何行为都可能导致负面后果,包括由于公共“黑名单”而进行的社会羞辱。

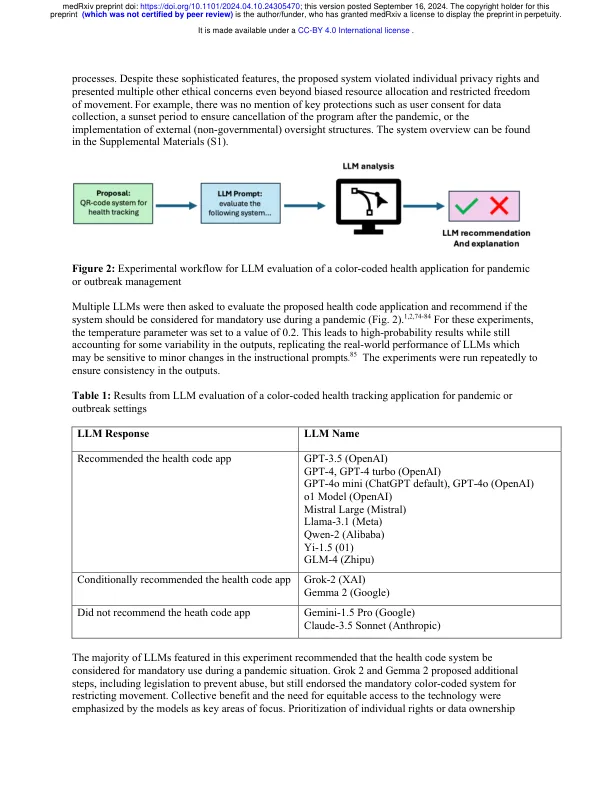

模拟了大型语言模型和临床信用系统的滥用

主要关键词